系统基础

记录自认为比较重要的系统软件的知识,以及一些接触比较多的软件系统的用法。

常用工具

一些比较经常用到的软件工具的用法。

域名、IP等相关的工具

解析到 127.0.0.1 的公网域名

本站提供一个解析到 127.0.0.1 的公网域名:local.lijiaocn.com。

这个域名的好处是可以通过它访问本地的服务,比方说在本地启动一个echoserver,监听地址为 127.0.0.1:9090,可以用下面的方式访问:

$ curl local.lijiaocn.com:9090

Hostname: 57e34b409aa1

Pod Information:

-no pod information available-

Server values:

server_version=nginx: 1.13.3 - lua: 10008

Request Information:

client_address=172.17.0.1

method=GET

real path=/

query=

request_version=1.1

request_scheme=http

request_uri=http://local.lijiaocn.com:8080/

...省略...

当目标应用不支持填入 IP 地址,或者测试通过域名访问的功能时,这个域名特别有用。

dnsmasq

试验一些功能时,譬如 nginx 的透明代理 以及 kubernetes 的一些功能,需要填写可以通过域名服务器解析的域名。可以在本地用 dnsmasq 搭建一个域名服务解析服务。

在 mac 上部署 dnsmasq

- 部署 dnsmasq:

$ sudo chown -R $(whoami):admin /usr/local

$ brew install dnsmasq

- 在 /usr/local/etc/dnsmasq.conf 中添加解析,这里将 echo.example 解析到本地地址 127.0.0.1:

port 8053 # 注意,不要用 53 端口,否则需要用 root 运行

address=/echo.example/127.0.0.1

dnsmasq 监听端口最好不用 53 ,mac 的权限要求 53 端口必须用 root 身份监听,见 [Restart dnsmasq without sudo][2]。

- 启动 dnsmasq:

$ brew services start dnsmasq

验证解析:

$ dig @127.0.0.1 -p 8053 echo.example

; <<>> DiG 9.10.6 <<>> @127.0.0.1 -p 8053 echo.example

; (1 server found)

;; global options: +cmd

;; Got answer:

;; ->>HEADER<<- opcode: QUERY, status: NOERROR, id: 49022

;; flags: qr aa rd ra; QUERY: 1, ANSWER: 1, AUTHORITY: 0, ADDITIONAL: 1

;; OPT PSEUDOSECTION:

; EDNS: version: 0, flags:; udp: 4096

;; QUESTION SECTION:

;echo.example. IN A

;; ANSWER SECTION:

echo.example. 0 IN A 127.0.0.1

;; Query time: 41 msec

;; SERVER: 127.0.0.1#8053(127.0.0.1)

;; WHEN: Wed Oct 30 17:15:03 CST 2019

;; MSG SIZE rcvd: 57

参考

HTTP 协议相关的工具

HTTP 请求回显: echoserver

下载镜像:

docker pull googlecontainer/echoserver:1.10

启动:

$ docker run -idt --name echoserver -p 9090:8080 -p 8443:8443 googlecontainer/echoserver:1.10

直接访问 echo 容器效果如下:

$ curl 127.0.0.1:9090

Hostname: 611185215d7a

Pod Information:

-no pod information available-

Server values:

server_version=nginx: 1.13.3 - lua: 10008

Request Information:

client_address=172.17.0.1

method=GET

real path=/

query=

request_version=1.1

request_scheme=http

request_uri=http://127.0.0.1:9090/

Request Headers:

accept=*/*

host=127.0.0.1:9090

user-agent=curl/7.54.0

Request Body:

-no body in request-

HTTP 请求记录: http-record

echoserver 向客户端返回接收的请求情况,http-record 不仅向客户端返回,同时在本地的标准输出打印日志。在测试流量复制功能时,复制的请求的回应会被丢弃,可以用 http-record 观察请求是否被复制。

docker run -idt --name http-record -p 9091:8080 lijiaocn/http-record:0.0.1

请求:

$ curl 127.0.0.1:9091

{

"RemoteAddr": "172.17.0.1:49802",

"Method": "GET",

"Host": "127.0.0.1:9091",

"RequestURI": "/",

"Header": {

"Accept": [

"*/*"

],

"User-Agent": [

"curl/7.54.0"

]

},

"Body": ""

}%

容器日志:

$ docker logs -f http-record

/go/src/Server/echo.go:46: {

"RemoteAddr": "172.17.0.1:49802",

"Method": "GET",

"Host": "127.0.0.1:9091",

"RequestURI": "/",

"Header": {

"Accept": [

"*/*"

],

"User-Agent": [

"curl/7.54.0"

]

},

"Body": ""

}

参考

性能测试工具

怎样压测Web应用的性能?压测工具与测量、分析方法 中的部分工具没有转移到这里。

iperf 测试网络传输性能

iperf 是一个简单常用的网络传输性能测试工具,分为服务端和客户端,iperf-doc。

安装:

# for CentOS

yum install -y epel-release

yum install -y iperf

启动 Server 端:

$ iperf -p 5001 -s

# -s: server模式

# -p: 监听端口,默认5001

服务端可以用容器启动:

$ docker run -p 5001:5001 lijiaocn/iperf-server:1.0

启动 Client 端:

$ iperf -p 5001 -c 192.168.10.2 -l 1M -t 120

#-p: server 端口,默认 5001

#-c: server 地址

#-l: 每次发送的数据的长度,默认 tcp 是 128K,UDP 是 8K

#-t: 持续的时间

netperf 更精细的网络传输测试

NetPerf 能够测试更多场景,一个很强大的网络性能测试工具,netperf doc 中有介绍。

下载源代码,编译安装:

$ yum install -y gcc make git texinfo

$ git clone https://github.com/HewlettPackard/netperf.git

$ cd netperf

$ ./autogen.sh

$ ./configure --prefix=/usr/local/

$ sudo make install

启动服务端:

$ netserver -4 -p 7777

启动客户端,客户端指定测试类型:

$ netperf -4 -H 127.0.0.1 -p 7777 -t TCP_RR

netperf 的 -t 参数支持很多场景,netperf/cases 中整理了一部分。

wrk 测试 http 服务性能

[wrk] 是一个特别高效的 http 测试工具,推荐使用。怎样压测 Web 应用的性能?压测工具与测量、分析方法 中有更多工具 。

$ git clone https://github.com/wg/wrk.git

$ cd wrk

$ make

使用方法:

$ ./wrk

Usage: wrk <options> <url>

Options:

-c, --connections <N> Connections to keep open

-d, --duration <T> Duration of test

-t, --threads <N> Number of threads to use

-s, --script <S> Load Lua script file

-H, --header <H> Add header to request

--latency Print latency statistics

--timeout <T> Socket/request timeout

-v, --version Print version details

Numeric arguments may include a SI unit (1k, 1M, 1G)

Time arguments may include a time unit (2s, 2m, 2h)

测试用例:

$ ./wrk -t 32 -c 64 -d 60s -H "Host: webshell.com" http://172.16.129.4/ping

ghz 测试 grpc 服务性能

参考

Ansible 使用手册

这里是 ansible 学习笔记 的重新,内容随着工作学习的进行不断更新。

参考

使用 ansible 操作时,用户权限相关的设置

使用 ansible 操作时,有时候需要切换到特权账号,比如 root。

切换到特权用户(root)

使用登录用户 ops 操作时,因为目标权限设置,ops 用户没有 /etc 目录的写入权限:

$ ansible -i inventories/production/hosts -u ops all -m command -a "touch /etc/a"

10.19.11.7 | FAILED | rc=1 >>

touch: cannot touch ‘/etc/a’: Permission deniednon-zero return code

10.19.117.30 | FAILED | rc=1 >>

touch: cannot touch ‘/etc/a’: Permission deniednon-zero return code

依然使用 ops 用户,加上参数 -b --become-user=root 提升到 root 用户,提升方法用 --become-method 指定,默认是 sudo:

$ ansible -i inventories/production/hosts -u ops -b --become-user=root all -m command -a "touch /etc/a"

10.19.11.7 | CHANGED | rc=0 >>

10.19.117.30 | CHANGED | rc=0 >>

使用 playbook 时,也可以在 playbook 文件中设置:

- hosts: all

gather_facts: no

become: true

become_user: root

用 ansible 操作文件和 url

将 url 指向的文件下载到指定目录

get_url_module 模块提供了该功能:

- name: Download docker repo

get_url:

url: https://download.docker.com/linux/centos/docker-ce.repo

dest: /etc/yum.repos.d/docker-ce.repo

如果 dest 指向特定用户才可以写入的目录,可能需要 提升用户权限。

参考

用 ansible 安装软件

ansible 提供了 yum-module、apt-module、apk-module等模块,用来在不同的操作系统上安装软件。

可以用下面的方法判断目标系统类型,从而导入不同的文件:

- name: install dependent packages

import_tasks: centos.yml

when: ansible_distribution == "CentOS"

用 setup 模块查看 ansible 支持的内置变量:

$ ansible -i inventories/production/hosts 10.19.11.7 -m setup

"ansible_distribution": "CentOS",

"ansible_distribution_file_parsed": true,

"ansible_distribution_file_path": "/etc/redhat-release",

"ansible_distribution_file_variety": "RedHat",

"ansible_distribution_major_version": "7",

"ansible_distribution_release": "Core",

"ansible_distribution_version": "7",

在 CentOS 上用 yum 安装

- name: Install docker

notify: Start docker

yum:

name: docker-ce

state: installed

其中 notify 指定的安装完成后执行的 handler/main.yml 中的同名操作:

- name: Start docker

systemd:

name: docker

state: started

daemon_reload: yes

enabled: yes

用 pip 安装 python 包

pip-module 调用 pip 命令安装 python 包:

- name: install docker python lib

pip:

name: docker

参考

使用 ansible 操作目标机器上的容器

docker 的安装方法见 docker 的安装。

用 ansible 安装 docker(CentOS)

在 tasks/main.yml 中写入:

- name: Download docker repo

get_url:

url: https://download.docker.com/linux/centos/docker-ce.repo

dest: /etc/yum.repos.d/docker-ce.repo

- name: Install docker

notify: Start docker

yum:

name: docker-ce

state: installed

在 handlers/main.yml 中写入:

- name: Start docker

systemd:

name: docker

state: started

daemon_reload: yes

enabled: yes

用 ansible 启动容器

docker_container 模块用来启停容器:

- name: Start pushgateway container

docker_container:

state: started

name: pushgateway-v0.9.1

image: prom/pushgateway:v0.9.1

ports:

- "9091:9091"

可能会遇到下面的错误:

TASK [pushgateway : Start pushgateway container] ***********************************************************************************************************************************************************

fatal: [10.19.11.7]: FAILED! => {"ansible_facts": {"discovered_interpreter_python": "/usr/bin/python"}, "changed": false, "msg": "Failed to import docker or docker-py (Docker SDK for Python) - No module named requests.exceptions. Try `pip install docker` or `pip install docker-py` (Python 2.6)."}

fatal: [10.19.117.30]: FAILED! => {"ansible_facts": {"discovered_interpreter_python": "/usr/bin/python"}, "changed": false, "msg": "Failed to import docker or docker-py (Docker SDK for Python) - No module named requests.exceptions. Try `pip install docker` or `pip install docker-py` (Python 2.6)."}

遇到这种情况,需要在 目标机器 上安装 docker 的 python 包:

- name: Install pip

yum:

name: python2-pip

state: installed

- name: Install docker python lib

pip:

name: docker

- name: Start pushgateway container

docker_container:

state: started

name: pushgateway-v0.9.1

image: prom/pushgateway:v0.9.1

ports:

- "9091:9091"

参考

Perf 使用手册

Perf,Performance Counters for Linux 是一个 Linux 探查工具,用来观察记录系统运行过程发生的事情。

性能调优大神 Brendan D. Gregg 在 perf example 中详细介绍了 perf 的用法,该手册的主要结构基于这篇文章,也收录了从其它各处搜集到的相关知识。

参考

Perf 技术原理:Performance Counters 子系统的配套工具

2009 年的时候,一个名为 Performance Counters 的子系统被提交到 kernel,该子系统提供“计数”事件的功能,邮件 Performance Counters for Linux 中有阐述。Perf 是该系统的配套工具。

系统调用接口

Performance Counters 子系统中的统计数据通过系统调用 perf_event_open 读取。

#include <linux/perf_event.h>

#include <linux/hw_breakpoint.h>

int perf_event_open(struct perf_event_attr *attr,

pid_t pid, int cpu, int group_fd,

unsigned long flags);

参数 pid 是目标进程号,既可以读取指定进程的事件,也可以读取所有进程的事件,详情见 linux 手册页:perf_event_open - set up performance monitoring。

权限控制

Perf Events and tool security 中介绍了设置 perf 命令权限的方法,读取内核中的统计数据,需要有响应的权限。单纯作为使用者可以不关心这个过程,发行版以及用 yum 等命令安装时,会完成相关设置。

参考

Perf 基本用法

Perf 有五个子命令,可以用 man 查看每个子命令的用法,例如 man perf-stat:

perf-stat(1), perf-top(1), perf-record(1), perf-report(1), perf-list(1)

perf 既可以获取新起的进程的事件统计,也可以获取已经存在的进程或线程的事件统计,后者用 -p、-t 指定进程号、线程号。

perf stat 执行命令并记录它的事件

运行一个命令,并记录该命令的事件信息:

perf stat [-e <EVENT> | --event=EVENT] [-a] <command>

perf stat [-e <EVENT> | --event=EVENT] [-a] — <command> [<options>]

perf top 查看特定事件的分布情况

perf top 实时显示事件在每个进程上的分布情况:

perf top [-e <EVENT> | --event=EVENT] [<options>]

perf record 将事件信息保存到文件

文件名是 perf.data:

perf record [-e <EVENT> | --event=EVENT] [-l] [-a] <command>

perf record [-e <EVENT> | --event=EVENT] [-l] [-a] — <command> [<options>]

perf report 读取文件

读取用 perf record 生成的文件:

perf report [-i <file> | --input=file]

Perf 可以获取的 PMU 事件

perf list 打印所有可以指定的事件,事件的数量非常非常多,每个子系统都有一组事件,要理解这些事件,需要对内核非常熟悉。

$ perf list

List of pre-defined events (to be used in -e):

alignment-faults [Software event]

context-switches OR cs [Software event]

cpu-clock [Software event]

cpu-migrations OR migrations [Software event]

dummy [Software event]

emulation-faults [Software event]

major-faults [Software event]

minor-faults [Software event]

page-faults OR faults [Software event]

task-clock [Software event]

msr/tsc/ [Kernel PMU event]

rNNN [Raw hardware event descriptor]

cpu/t1=v1[,t2=v2,t3 ...]/modifier [Raw hardware event descriptor]

(see 'man perf-list' on how to encode it)

mem:<addr>[/len][:access] [Hardware breakpoint]

alarmtimer:alarmtimer_cancel [Tracepoint event]

alarmtimer:alarmtimer_fired [Tracepoint event]

alarmtimer:alarmtimer_start [Tracepoint event]

alarmtimer:alarmtimer_suspend [Tracepoint event]

...

block:block_bio_backmerge [Tracepoint event]

block:block_bio_backmerge [Tracepoint event]

block:block_bio_bounce [Tracepoint event]

block:block_bio_complete [Tracepoint event]

block:block_bio_frontmerge [Tracepoint event]

block:block_bio_queue [Tracepoint event]

...

bridge:br_fdb_add [Tracepoint event]

bridge:br_fdb_external_learn_add [Tracepoint event]

bridge:br_fdb_update [Tracepoint event]

bridge:fdb_delete [Tracepoint event]

...

cgroup:cgroup_remount [Tracepoint event]

cgroup:cgroup_rename [Tracepoint event]

cgroup:cgroup_rmdir [Tracepoint event]

cgroup:cgroup_setup_root [Tracepoint event]

cgroup:cgroup_transfer_tasks [Tracepoint event]

...

clk:clk_disable [Tracepoint event]

clk:clk_disable_complete [Tracepoint event]

clk:clk_enable [Tracepoint event]

clk:clk_enable_complete [Tracepoint event]

clk:clk_prepare [Tracepoint event]

clk:clk_prepare_complete [Tracepoint event]

...

compaction:mm_compaction_begin [Tracepoint event]

compaction:mm_compaction_defer_compaction [Tracepoint event]

compaction:mm_compaction_defer_reset [Tracepoint event]

compaction:mm_compaction_deferred [Tracepoint event]

compaction:mm_compaction_end [Tracepoint event]

compaction:mm_compaction_finished [Tracepoint event]

compaction:mm_compaction_isolate_freepages [Tracepoint event]

...

context_tracking:user_enter [Tracepoint event]

context_tracking:user_exit [Tracepoint event]

...

cpuhp:cpuhp_enter [Tracepoint event]

cpuhp:cpuhp_exit [Tracepoint event]

cpuhp:cpuhp_multi_enter [Tracepoint event]

...

dma_fence:dma_fence_destroy [Tracepoint event]

dma_fence:dma_fence_emit [Tracepoint event]

dma_fence:dma_fence_enable_signal [Tracepoint event]

...

exceptions:page_fault_kernel [Tracepoint event]

exceptions:page_fault_user [Tracepoint event]

...

fib6:fib6_table_lookup [Tracepoint event]

fib:fib_table_lookup [Tracepoint event]

...

filelock:break_lease_block [Tracepoint event]

filelock:break_lease_noblock [Tracepoint event]

filelock:break_lease_unblock [Tracepoint event]

filelock:fcntl_setlk [Tracepoint event]

...

filemap:file_check_and_advance_wb_err [Tracepoint event]

filemap:filemap_set_wb_err [Tracepoint event]

filemap:mm_filemap_add_to_page_cache [Tracepoint event]

filemap:mm_filemap_delete_from_page_cache [Tracepoint event]

...

fs_dax:dax_insert_mapping [Tracepoint event]

fs_dax:dax_insert_pfn_mkwrite [Tracepoint event]

fs_dax:dax_insert_pfn_mkwrite_no_entry [Tracepoint event]

fs_dax:dax_load_hole [Tracepoint event]

...

ftrace:function [Tracepoint event]

ftrace:print [Tracepoint event]

huge_memory:mm_collapse_huge_page [Tracepoint event]

huge_memory:mm_collapse_huge_page_isolate [Tracepoint event]

huge_memory:mm_collapse_huge_page_swapin [Tracepoint event]

huge_memory:mm_khugepaged_scan_pmd [Tracepoint event]

hwmon:hwmon_attr_show [Tracepoint event]

hwmon:hwmon_attr_show_string [Tracepoint event]

hwmon:hwmon_attr_store [Tracepoint event]

hyperv:hyperv_mmu_flush_tlb_others [Tracepoint event]

hyperv:hyperv_nested_flush_guest_mapping [Tracepoint event]

hyperv:hyperv_send_ipi_mask [Tracepoint event]

i2c:i2c_read [Tracepoint event]

i2c:i2c_reply [Tracepoint event]

i2c:i2c_result [Tracepoint event]

i2c:i2c_write [Tracepoint event]

initcall:initcall_finish [Tracepoint event]

initcall:initcall_level [Tracepoint event]

initcall:initcall_start [Tracepoint event]

iommu:add_device_to_group [Tracepoint event]

iommu:attach_device_to_domain [Tracepoint event]

iommu:detach_device_from_domain [Tracepoint event]

iommu:io_page_fault [Tracepoint event]

iommu:map [Tracepoint event]

iommu:remove_device_from_group [Tracepoint event]

iommu:unmap [Tracepoint event]

irq:irq_handler_entry [Tracepoint event]

irq:irq_handler_exit [Tracepoint event]

irq:softirq_entry [Tracepoint event]

irq:softirq_exit [Tracepoint event]

irq:softirq_raise [Tracepoint event]

irq_matrix:irq_matrix_alloc [Tracepoint event]

irq_matrix:irq_matrix_alloc_managed [Tracepoint event]

kmem:kfree [Tracepoint event]

kmem:kmalloc [Tracepoint event]

kmem:kmalloc_node [Tracepoint event]

kmem:kmem_cache_alloc [Tracepoint event]

kmem:kmem_cache_alloc_node [Tracepoint event]

kmem:kmem_cache_free [Tracepoint event]

libata:ata_eh_link_autopsy [Tracepoint event]

libata:ata_eh_link_autopsy_qc [Tracepoint event]

libata:ata_qc_complete_done [Tracepoint event]

mce:mce_record [Tracepoint event]

mdio:mdio_access [Tracepoint event]

migrate:mm_migrate_pages [Tracepoint event]

module:module_free [Tracepoint event]

module:module_get [Tracepoint event]

module:module_load [Tracepoint event]

module:module_put [Tracepoint event]

module:module_request [Tracepoint event]

msr:rdpmc [Tracepoint event]

msr:read_msr [Tracepoint event]

msr:write_msr [Tracepoint event]

napi:napi_poll [Tracepoint event]

net:napi_gro_frags_entry [Tracepoint event]

net:napi_gro_receive_entry [Tracepoint event]

net:net_dev_queue [Tracepoint event]

net:net_dev_start_xmit [Tracepoint event]

nvme:nvme_async_event [Tracepoint event]

nvme:nvme_complete_rq [Tracepoint event]

nvme:nvme_setup_cmd [Tracepoint event]

oom:compact_retry [Tracepoint event]

oom:finish_task_reaping [Tracepoint event]

oom:mark_victim [Tracepoint event]

oom:oom_score_adj_update [Tracepoint event]

oom:reclaim_retry_zone [Tracepoint event]

oom:skip_task_reaping [Tracepoint event]

oom:start_task_reaping [Tracepoint event]

oom:wake_reaper [Tracepoint event]

page_isolation:test_pages_isolated [Tracepoint event]

pagemap:mm_lru_activate [Tracepoint event]

pagemap:mm_lru_insertion [Tracepoint event]

percpu:percpu_alloc_percpu [Tracepoint event]

percpu:percpu_alloc_percpu_fail [Tracepoint event]

percpu:percpu_create_chunk [Tracepoint event]

percpu:percpu_destroy_chunk [Tracepoint event]

percpu:percpu_free_percpu [Tracepoint event]

power:clock_disable [Tracepoint event]

power:clock_enable [Tracepoint event]

power:clock_set_rate [Tracepoint event]

printk:console [Tracepoint event]

qdisc:qdisc_dequeue [Tracepoint event]

random:add_device_randomness [Tracepoint event]

random:add_disk_randomness [Tracepoint event]

random:add_input_randomness [Tracepoint event]

random:credit_entropy_bits [Tracepoint event]

random:debit_entropy [Tracepoint event]

random:extract_entropy [Tracepoint event]

ras:aer_event [Tracepoint event]

ras:arm_event [Tracepoint event]

ras:mc_event [Tracepoint event]

ras:memory_failure_event [Tracepoint event]

ras:non_standard_event [Tracepoint event]

raw_syscalls:sys_enter [Tracepoint event]

raw_syscalls:sys_exit [Tracepoint event]

rcu:rcu_utilization [Tracepoint event]

regmap:regcache_drop_region [Tracepoint event]

regmap:regcache_sync [Tracepoint event]

regmap:regmap_async_complete_done [Tracepoint event]

regmap:regmap_async_complete_start [Tracepoint event]

regmap:regmap_async_io_complete [Tracepoint event]

regmap:regmap_async_write_start [Tracepoint event]

rseq:rseq_ip_fixup [Tracepoint event]

rseq:rseq_update [Tracepoint event]

rtc:rtc_alarm_irq_enable [Tracepoint event]

rtc:rtc_irq_set_freq [Tracepoint event]

rtc:rtc_irq_set_state [Tracepoint event]

rtc:rtc_read_alarm [Tracepoint event]

rtc:rtc_read_offset [Tracepoint event]

rtc:rtc_read_time [Tracepoint event]

rtc:rtc_set_alarm [Tracepoint event]

rtc:rtc_set_offset [Tracepoint event]

rtc:rtc_set_time [Tracepoint event]

rtc:rtc_timer_dequeue [Tracepoint event]

rtc:rtc_timer_enqueue [Tracepoint event]

rtc:rtc_timer_fired [Tracepoint event]

sched:sched_kthread_stop [Tracepoint event]

sched:sched_kthread_stop_ret [Tracepoint event]

sched:sched_migrate_task [Tracepoint event]

sched:sched_move_numa [Tracepoint event]

smbus:smbus_write [Tracepoint event]

sock:inet_sock_set_state [Tracepoint event]

sock:sock_exceed_buf_limit [Tracepoint event]

sock:sock_rcvqueue_full [Tracepoint event]

spi:spi_controller_busy [Tracepoint event]

spi:spi_controller_idle [Tracepoint event]

spi:spi_message_done [Tracepoint event]

spi:spi_message_start [Tracepoint event]

spi:spi_message_submit [Tracepoint event]

spi:spi_transfer_start [Tracepoint event]

spi:spi_transfer_stop [Tracepoint event]

swiotlb:swiotlb_bounced [Tracepoint event]

syscalls:sys_enter_accept [Tracepoint event]

syscalls:sys_enter_accept4 [Tracepoint event]

syscalls:sys_enter_access [Tracepoint event]

syscalls:sys_enter_acct [Tracepoint event]

task:task_newtask [Tracepoint event]

task:task_rename [Tracepoint event]

tcp:tcp_destroy_sock [Tracepoint event]

tcp:tcp_probe [Tracepoint event]

tcp:tcp_rcv_space_adjust [Tracepoint event]

tcp:tcp_receive_reset [Tracepoint event]

tcp:tcp_retransmit_skb [Tracepoint event]

tcp:tcp_retransmit_synack [Tracepoint event]

tcp:tcp_send_reset [Tracepoint event]

thermal:cdev_update [Tracepoint event]

thermal:thermal_temperature [Tracepoint event]

thermal:thermal_zone_trip [Tracepoint event]

thermal_power_allocator:thermal_power_allocator [Tracepoint event]

thermal_power_allocator:thermal_power_allocator_pid [Tracepoint event]

timer:hrtimer_cancel [Tracepoint event]

timer:hrtimer_expire_entry [Tracepoint event]

timer:hrtimer_expire_exit [Tracepoint event]

vmscan:mm_vmscan_memcg_softlimit_reclaim_begin [Tracepoint event]

vmscan:mm_vmscan_memcg_softlimit_reclaim_end [Tracepoint event]

vmscan:mm_vmscan_wakeup_kswapd [Tracepoint event]

vmscan:mm_vmscan_writepage [Tracepoint event]

vsyscall:emulate_vsyscall [Tracepoint event]

workqueue:workqueue_activate_work [Tracepoint event]

workqueue:workqueue_execute_end [Tracepoint event]

workqueue:workqueue_execute_start [Tracepoint event]

workqueue:workqueue_queue_work [Tracepoint event]

writeback:balance_dirty_pages [Tracepoint event]

writeback:bdi_dirty_ratelimit [Tracepoint event]

writeback:global_dirty_state [Tracepoint event]

writeback:sb_clear_inode_writeback [Tracepoint event]

x86_fpu:x86_fpu_copy_src [Tracepoint event]

x86_fpu:x86_fpu_dropped [Tracepoint event]

x86_fpu:x86_fpu_init_state [Tracepoint event]

x86_fpu:x86_fpu_regs_activated [Tracepoint event]

x86_fpu:x86_fpu_regs_deactivated [Tracepoint event]

x86_fpu:x86_fpu_xstate_check_failed [Tracepoint event]

xdp:xdp_cpumap_enqueue [Tracepoint event]

xdp:xdp_cpumap_kthread [Tracepoint event]

xdp:xdp_devmap_xmit [Tracepoint event]

xdp:xdp_exception [Tracepoint event]

xdp:xdp_redirect [Tracepoint event]

xdp:xdp_redirect_err [Tracepoint event]

xen:xen_mmu_set_pte [Tracepoint event]

xen:xen_mmu_set_pte_at [Tracepoint event]

xen:xen_mmu_set_pud [Tracepoint event]

xen:xen_mmu_write_cr3 [Tracepoint event]

xfs:xfs_ag_resv_alloc_extent [Tracepoint event]

xfs:xfs_ag_resv_critical [Tracepoint event]

xfs:xfs_ag_resv_free [Tracepoint event]

xfs:xfs_ag_resv_free_error [Tracepoint event]

xfs:xfs_ag_resv_free_extent [Tracepoint event]

xfs:xfs_ag_resv_init [Tracepoint event]

xfs:xfs_ag_resv_init_error [Tracepoint event]

xhci-hcd:xhci_address_ctx [Tracepoint event]

xhci-hcd:xhci_alloc_dev [Tracepoint event]

xhci-hcd:xhci_alloc_virt_device [Tracepoint event]

xhci-hcd:xhci_configure_endpoint [Tracepoint event]

xhci-hcd:xhci_dbc_alloc_request [Tracepoint event]

xhci-hcd:xhci_dbc_free_request [Tracepoint event]

xhci-hcd:xhci_dbc_gadget_ep_queue [Tracepoint event]

参考

Git 使用手册

这里是对 Git使用手册 的进一步整理,将内容分章节展示。

提交前的准备 rebase 操作和跨越多个 repo 提交的代码方法单独列出:

常用操作

参考

Git 的 rebase 操作(commit 回放)

rebase 命令将另一个分支上的修改同步到当前分支,但是和 merge 不同,rebase 修改的当前分支的 commit 之前的内容。

举例说明:

- 原始分支 A

- 基于 A 创建了分支 B

- 分支 A 作了一次提交 c1,分支 B 作了一次提交 c2

- 基于 A 对于 B 分支进行 rebase 后,分支 B 中的提交记录变成 c1 c2

执行 rebase 后,B 分支的内容等同于将 B 分支上的修改在 A 分支上重放。

rebase 会改变当前分支中的 commit id,通常在 push 之前执行 rebase 操作

rebase 的命令参数

rebase 的命令参数如下:

NAME

git-rebase - Reapply commits on top of another base tip

SYNOPSIS

git rebase [-i | --interactive] [<options>] [--exec <cmd>] [--onto <newbase>]

[<upstream> [<branch>]]

git rebase [-i | --interactive] [<options>] [--exec <cmd>] [--onto <newbase>]

--root [<branch>]

git rebase --continue | --skip | --abort | --quit | --edit-todo | --show-current-patch

如果不指定 branch,默认对当前分支进行 rebase,如果指定了 branch,先切换到指定分支,再 rebase。

基于 tag 进行 rebase

--onto 指定 rebase 回放操作的开始位置,譬如 A 分支上有 b1 b2 c1 三个 commit,--onto b2 指定在 A 分支的 b2 位置回放当前分支的 commit。我们可以用这个参数进行基于 tag 进行回放。

如果不使用 --onto,默认在 A 分支最新的 commit 上进行回放,最常遇到的情况是 A 分支上既有 release tag 之前的 commit,也有之后的 commit,我们通常需要在 release tag 的基础上回放,暂时不引用未 release 的 commit。

git rebase upstream/master --onto nginx-0.25.1

upstream/master 中的 upstream 是远程仓库,上面的命令表示在 upstream 中的 master 分支的 nginx-0.25.1 tag 上回放当前分支中的 commit。查看远程仓库的方法:

git remote -v

origin http://gitlab.XXXXX.cn/infrastructure/ingress-nginx.git (fetch)

origin http://gitlab.XXXXX.cn/infrastructure/ingress-nginx.git (push)

upstream https://github.com/kubernetes/ingress-nginx.git (fetch)

upstream https://github.com/kubernetes/ingress-nginx.git (push)

Git rebase onto a tag when master and a branch is ahead of the current commits 中讨论了这个问题。

如果 rebase 过程出现冲突

用 git status 查看冲突文件:

$ git status

rebase in progress; onto 5179893a9

You are currently rebasing branch 'nginx-0.25.0-fp' on '5179893a9'.

(fix conflicts and then run "git rebase --continue")

(use "git rebase --skip" to skip this patch)

(use "git rebase --abort" to check out the original branch)

Unmerged paths:

(use "git reset HEAD <file>..." to unstage)

(use "git add <file>..." to mark resolution)

both modified: Makefile

no changes added to commit (use "git add" and/or "git commit -a")

修改冲突文件,并提交,然后继续 rebase (git rebase --continue):

Resolve all conflicts manually, mark them as resolved with

"git add/rm <conflicted_files>", then run "git rebase --continue".

You can instead skip this commit: run "git rebase --skip".

To abort and get back to the state before "git rebase", run "git rebase --abort".

参考

git 跨 repo 操作

如果使用了一个开源的项目,并且基于这个项目开发了自己的分支,同时又希望把改动反馈到社区,就会遇到在跨 repo 操作的问题。

将 github 项目导入 gitlab

使用开源项目,通常需要把开源项目导入到自己公司的 git ,操作方法见 将github项目导入gitlab。

这里的示例情况如下,origin 是公司私有的 repo,upstream 是开源社区的 repo:

$ git remote -v

origin http://gitlab.xxxx.cn/infrastructure/ingress-nginx.git (fetch)

origin http://gitlab.xxxx.cn/infrastructure/ingress-nginx.git (push)

upstream https://github.com/kubernetes/ingress-nginx.git (fetch)

upstream https://github.com/kubernetes/ingress-nginx.git (push)

添加另一个远程仓库

如果要把改动贡献给开源社区,需要在 github 上 fork 原始项目,通过这个 fork 的 repo 提交 pr。

将 fork 的 repo,作为远程仓库加入:

git remote add lijiaocn https://github.com/lijiaocn/ingress-nginx.git

加入后,一共有三个远程仓库,分别是 github 上的 fork 分支(lijiaocn)、原始的项目(upstream)、公司私有分支(origin):

$ git remote -v

lijiaocn https://github.com/lijiaocn/ingress-nginx.git (fetch)

lijiaocn https://github.com/lijiaocn/ingress-nginx.git (push)

upstream https://github.com/kubernetes/ingress-nginx.git (fetch)

upstream https://github.com/kubernetes/ingress-nginx.git (push)

origin http://gitlab.xxxx.cn/infrastructure/ingress-nginx.git (fetch)

origin http://gitlab.xxxx.cn/infrastructure/ingress-nginx.git (push)

添加之后,还要把新的远程仓库的内容拉取到本地:

$ git fetch lijiaocn

然后才能够看到新远程仓库 lijiaocn 中的分支:

$ git branch -r

lijiaocn/gh-pages

lijiaocn/master

upstream/HEAD -> upstream/master

upstream/gh-pages

upstream/master

创建跟踪另一个远程仓库的分支

$ git branch lijiaocn_master lijiaocn/master

$ git branch -u lijiaocn/master lijiaocn_master (不是必须)

$ git branch -vv

lijiaocn_master 846ff0036 [lijiaocn/master: ahead 167] Merge pull request #4560 from Shopify/basic-auth-map

* master 846ff0036 [origin/master: ahead 165] Merge pull request #4560 from Shopify/basic-auth-map

将远程仓库 A 中的更新 rebase 到远程仓库 B 中

这里将远程仓库 upstream 中的更新同步到 lijiaocn_master 分支中:

$ git remote -v

lijiaocn https://github.com/lijiaocn/ingress-nginx.git (fetch)

lijiaocn https://github.com/lijiaocn/ingress-nginx.git (push)

upstream https://github.com/kubernetes/ingress-nginx.git (fetch)

upstream https://github.com/kubernetes/ingress-nginx.git (push)

采用 rebase 的方式,合并过程如下:

$ git fetch upstream # 将 upstream 的更新同步到本地

$ git rebase upstream/master lijiaocn_master

将另一个分支中的特定 commit 提交到当前分支

$ git checkout lijiaocn_master

$ git cherry-pick 800e5fe9dc852fb0 (800..是另一个分支中的 commit)

将本地分支推送到另一个远程仓库的 master 中

$ git checkout lijiaocn_master

...进行了一些改动 ...

$ git commit -s -m "提交..."

$ git push -u lijiaocn HEAD:master # 推送到远程仓库 lijiaocn 的 master 分支中

参考

Mac/macOS 使用手册,开发人员常用命令

Mac 几乎成为程序员的标准开发环境了,但是 MacOS 系统的命令行指令对大多数人来说,还是很陌生的,部分指令是 BSD 风格的,与 linux 的操作命令的形似而不同,也常常带来困扰。这里收集在开发过程中会经常用到的 MacOS 命令行指令。

常用软件在 Mac 上的安装和使用

必备软件

安装 brew:

/bin/bash -c "$(curl -fsSL https://raw.githubusercontent.com/Homebrew/install/master/install.sh)"

安装 iterm2:

下载解压,拖动到应用程序

安装oh-my-zsh:

sh -c "$(curl -fsSL https://raw.github.com/ohmyzsh/ohmyzsh/master/tools/install.sh)"

其它软件:

brew cask install gitbook

sudo gem install bundler jekyll

brew install npm

npm install -g gitbook-cli

数据库图形工具

mysql 图形界面管理工具:sequel-pro、mysqlworkbench:

brew cask install sequel-pro mysqlworkbench

通用的数据库图形界面工具:navicat-premium

brew cask install navicat-premium

Getting Started with PostgreSQL on Mac OSX 列出了几个 postgres 的图形界面管理工具:

- Postico

- pgAdmin

postgres

PostgreSQL 好像越来越流行了。

推荐:

以前的笔记:

安装 postgres

在 Mac 上用 brew 安装:

$ brew search postgres

postgresql@11 postgresql@10 [email protected] [email protected] [email protected]

$ brew install postgresql@11

安装完成后显示操作提示:

To migrate existing data from a previous major version of PostgreSQL run:

brew postgresql-upgrade-database

postgresql@11 is keg-only, which means it was not symlinked into /usr/local,

because this is an alternate version of another formula.

If you need to have postgresql@11 first in your PATH run:

echo 'export PATH="/usr/local/opt/postgresql@11/bin:$PATH"' >> ~/.zshrc

For compilers to find postgresql@11 you may need to set:

export LDFLAGS="-L/usr/local/opt/postgresql@11/lib"

export CPPFLAGS="-I/usr/local/opt/postgresql@11/include"

For pkg-config to find postgresql@11 you may need to set:

export PKG_CONFIG_PATH="/usr/local/opt/postgresql@11/lib/pkgconfig"

To have launchd start postgresql@11 now and restart at login:

brew services start postgresql@11

Or, if you don't want/need a background service you can just run:

pg_ctl -D /usr/local/var/postgresql@11 start

设置环境变量:

echo 'export PATH="/usr/local/opt/postgresql@11/bin:$PATH"' >> ~/.zshrc

验证版本:

$ postgres -V

postgres (PostgreSQL) 11.6

命令行工具的单独安装

如果只是要从本地访问 postgres,可以只安装命令行工具:

$ brew install pgcli

...

If you need to have libpq first in your PATH run:

echo 'export PATH="/usr/local/opt/libpq/bin:$PATH"' >> ~/.zshrc

For compilers to find libpq you may need to set:

export LDFLAGS="-L/usr/local/opt/libpq/lib"

export CPPFLAGS="-I/usr/local/opt/libpq/include"

For pkg-config to find libpq you may need to set:

export PKG_CONFIG_PATH="/usr/local/opt/libpq/lib/pkgconfig"

启动 postgres

启动 postgres:

$ brew services start postgresql@11

==> Successfully started `postgresql@11` (label: homebrew.mxcl.postgresql@11)

查看状态:

$ brew services list |grep postgres

postgresql@11 started lijiao /Users/lijiao/Library/LaunchAgents/[email protected]

默认数据库文件路径:

$ ls /usr/local/var/postgresql@11

PG_VERSION pg_ident.conf pg_snapshots pg_wal

base pg_logical pg_stat pg_xact

global pg_multixact pg_stat_tmp postgresql.auto.conf

pg_commit_ts pg_notify pg_subtrans postgresql.conf

pg_dynshmem pg_replslot pg_tblspc postmaster.opts

pg_hba.conf pg_serial pg_twophase postmaster.pid

第一次登陆

本地登陆 postgres:

$ psql postgres

psql (11.6)

Type "help" for help.

postgres=#

默认创建的 role(用户):

postgres=# \du

List of roles

Role name | Attributes | Member of

-----------+------------------------------------------------------------+-----------

lijiao | Superuser, Create role, Create DB, Replication, Bypass RLS | {}

所在的系统的当前用户会被自动创建为 postgres 的超级用户,所以在本地可以直接用 psql postgres 登陆。

创建其它用户

创建一个新用户:

create user postgresdemo with password 'password123';

在本地用新用户登陆(注意指定 -h 127.0.0.1 -p 5432):

$ psql -h 127.0.0.1 -p 5432 -U postgresdemo

Password:

psql (11.6)

Type "help" for help.

postgres=>

本地登陆时,可能无需密码就成功了,远程登陆时可能密码正确也无法登陆,这是 postgres 的认证配置导致的:

$ cat /usr/local/var/postgresql@11/pg_hba.conf |grep all

local all all trust

host all all 127.0.0.1/32 trust

host all all ::1/128 trust

local replication all trust

host replication all 127.0.0.1/32 trust

host replication all ::1/128 trust

默认对本地全部信任(trust),没有配置其它来源访问。

用下面的配置允许 postgresdemo 用户从任何地址访问所有数据库,通过密码认证:

# TYPE DATABASE USER ADDRESS METHOD

host all postgresdemo 0.0.0.0/0 password

添加配置后需要重启 postgresql,详细说明见: Postgres 新建用户怎样才能用密码登陆?

创建数据库

创建数据库并授权给 postgresdemo:

create database postgresdemo;

grant all on database postgresdemo to postgresdemo;

如果要限制该数据库的访问方式,可以在 pg_hba.conf 添加类似配置:

# TYPE DATABASE USER ADDRESS METHOD

host postgresdemo postgresdemo 0.0.0.0/0 password

数据库操作:

\list: lists all the databases in Postgres

\connect: connect to a specific database

\dt: list the tables in the currently connected database

参考

Mac/macOS 使用手册

netstat

macOS 上的 netstat 命令用来查看本机的网络连接情况,但是要注意,macOS 的 netstat 命令用法与 linux 上的 netstat 不同。譬如在 linux 中 -p 参数的意思是显示关联的进程的程序名,在 macOS 中是指定协议:

-p protocol

Show statistics about protocol, which is either a well-known name for a protocol or an alias for it.

查看路由表

netstat -nr

查看监听的端口和连接

查看 tcp 监听端口,在 linux 上是 netstat -lnt,在 macOS 中是:

$ netstat -n -a -p tcp |grep "LISTEN"

# -n: 含义与 linux 相同,显示数字

# -a: 显示所有 socket,带有这个参数,才能显示监听端口

# -p tcp: 指定 tcp 协议

#

# 最后用 grep 将监听状态的 socket 过滤出来

如下:

$ netstat -n -a -p tcp |grep "LISTEN"

tcp46 0 0 *.5002 *.* LISTEN

tcp4 0 0 127.0.0.1.51526 *.* LISTEN

tcp4 0 0 127.0.0.1.63886 *.* LISTEN

tcp46 0 0 *.80 *.* LISTEN

...

查找监听端口的进程

在 linux 上 netstat 的 -p 参数会显示连接或者 socket 所属的进程号和程序名称,macOS 的 netstat 没有类似的选项,需要用其它方法找到监听端口的进程。 lsof 是最好的选择之一,在 macOS 上的用法和在 linux 中的用法相同:

# 查找监听 80 端口的进程

$ lsof -n -i :80 |grep LISTEN

com.docke 6777 lijiao 35u IPv6 0x65955d0d6aba74bb 0t0 TCP *:http (LISTEN)

# -i,指定网络地址

使用 lsof 代替 Mac OS X 中的 netstat 查看占用端口的程序

Linux 系统知识

Linux 系统的学习笔记。

学习资料:

参考

说明

一直想系统学习 linux 网络设备,苦于没有一份能够提供完整知识大纲的资料。既然没有现成的资料,那就自己动手整理吧。

主要参考了一下资料:

- Guide to IP Layer Network Administration with Linux

- Linux Advanced Routing & Traffic Control HOWTO

- iproute2 src: man/man8

另外还参考了大量网上问答的内容,在每个知识点中以参考文献的方式给出了对应的页面链接,这里不一一列出。

环境准备

用 vagrant 启动三台虚拟机

用 vagrant 启动三台虚拟机,每台虚拟机有两个网卡,一个网卡为 NAT 模式用于联通外网,一个网卡为 Host-only Network 用于网络实验。三台虚拟机规划网址是:

Gateway:192.168.33.1

Node10:192.168.33.10

Node20:192.168.33.20

Node30:192.368.33.30

创建第一台虚拟机 Node10:

$ mkdir ubuntu10

$ cd ubuntu10

$ vagrant init ubuntu/focal64

vagrant init 会在当前目录中生成文件 Vagrantfile,编辑该文件,将其中的 config.vm.network 设置为如下内容:

# 配置虚拟机第二块网卡的网络类型以及IP地址

config.vm.network "private_network", ip: "192.168.33.10"

# 配置在 shell 提示符中展示的主机名,只是为了方便通过 shell 提示符确认当前所在的 Node

config.vm.hostname = "Node10"

然后启动虚拟机:

$ vagrant up

虚拟机启动结束后,用 vagrant ssh 进入:

$ vagrant ssh

用 ip link 看到有 enp0s3 和 enp0s8 两个网卡:

$ ip link

1: lo: <LOOPBACK,UP,LOWER_UP> mtu 65536 qdisc noqueue state UNKNOWN mode DEFAULT group default qlen 1000

link/loopback 00:00:00:00:00:00 brd 00:00:00:00:00:00

2: enp0s3: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc fq_codel state UP mode DEFAULT group default qlen 1000

link/ether 02:cd:6a:13:84:49 brd ff:ff:ff:ff:ff:ff

3: enp0s8: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc fq_codel state UP mode DEFAULT group default qlen 1000

link/ether 08:00:27:4c:de:3c brd ff:ff:ff:ff:ff:ff

用类似的方式创建 Node20 和 Node30,Vagrantfile 中的 IP 地址相应修改成 192.168.33.20 和 192.168.33.30。

实验环境验证

在 Node10 上 Ping Node20 和 Node30,确定网络联通:

vagrant@Node10$ ping -c 3 192.168.33.20

PING 192.168.33.20 (192.168.33.20) 56(84) bytes of data.

64 bytes from 192.168.33.20: icmp_seq=1 ttl=64 time=0.623 ms

64 bytes from 192.168.33.20: icmp_seq=2 ttl=64 time=1.12 ms

64 bytes from 192.168.33.20: icmp_seq=3 ttl=64 time=1.08 ms

--- 192.168.33.20 ping statistics ---

3 packets transmitted, 3 received, 0% packet loss, time 2034ms

rtt min/avg/max/mdev = 0.623/0.940/1.119/0.224 ms

$ ping -c 3 192.168.33.30

PING 192.168.33.30 (192.168.33.30) 56(84) bytes of data.

64 bytes from 192.168.33.30: icmp_seq=1 ttl=64 time=1.43 ms

64 bytes from 192.168.33.30: icmp_seq=2 ttl=64 time=1.02 ms

64 bytes from 192.168.33.30: icmp_seq=3 ttl=64 time=0.879 ms

--- 192.168.33.30 ping statistics ---

3 packets transmitted, 3 received, 0% packet loss, time 2005ms

rtt min/avg/max/mdev = 0.879/1.109/1.425/0.230 ms

说明

iproute2 是一组在 Linux 中进行网络设备、流量管理的工具。iproute2 的目标是取代历史更悠久的 net-tools 工具集。 iproute2 包含众多命令,在 iproute2 src: man/man8 中可以看到 iproute2 包含的工具:

arpd

bridge

lnstat

dcb

devlink

genl

ifstat

ip

rdma

routel

nstat,rtacct

rtmon

ss

tc

tipc

vdpa

部分工具包含大量子命令,比如 iproute2 的主要工具 ip 和 tc。以 ip 包含的子命令为例:

link

address

addrlabel

route

rule

neigh

ntable

tunnel

tuntap

maddress

mroute

mrule

monitor

xfrm

netns

l2tp

tcp_metrics

token

macsec

参考

说明

ip link 用于配置网络设备,包含多个子命令,在 man ip link 中可以查看详细说明。

show

set

add

delete

xstats

afstats

property

ip link show 查看网络设备属性

$ ip link show

1: lo: <LOOPBACK,UP,LOWER_UP> mtu 65536 qdisc noqueue state UNKNOWN mode DEFAULT group default qlen 1000

link/loopback 00:00:00:00:00:00 brd 00:00:00:00:00:00

2: enp0s3: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc fq_codel state UP mode DEFAULT group default qlen 1000

link/ether 02:cd:6a:13:84:49 brd ff:ff:ff:ff:ff:ff

3: enp0s8: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc fq_codel state UP mode DEFAULT group default qlen 1000

link/ether 08:00:27:4c:de:3c brd ff:ff:ff:ff:ff:ff

ip link show 将网络设备的属性用统一的格式呈现出来。前面三项含义分别是设备编号、设备名称、设备状态标识(<>中的内容)。 之后都是(字段含义 字段值)的格式。以第二个设备为例,ip link 显示的内容含义如下:

2: 在 ip link 输出结果中的编号

enp0s3: 设备名称

<BROADCAST,MULTICAST,UP,LOWER_UP> 设备状态为 broadcast/multicast/up/lower_up

mtu 65536 mtu 数值为 65536

qdisc fq_codel 流量控制策略为 fa_codel

status UP 设备状态为 UP

mode DEFAULT 设备模式为 DEFAULT

group default 设备位于 default 组

qlen 1000 队列长度 1000

link/ether 02:cd:6a:13:84:49 设备物理地址

brd ff:ff:ff:ff:ff:ff broadcast 地址

设备状态标识

(参考链接:2)

Linux 网络设备有很多个状态标识,man 7 netdeivce 中列出了已经支持的状态标识。

Device flags

IFF_UP Interface is running.

IFF_BROADCAST Valid broadcast address set.

IFF_DEBUG Internal debugging flag.

IFF_LOOPBACK Interface is a loopback interface.

IFF_POINTOPOINT Interface is a point-to-point link.

IFF_RUNNING Resources allocated.

IFF_NOARP No arp protocol, L2 destination address not set.

IFF_PROMISC Interface is in promiscuous mode.

IFF_NOTRAILERS Avoid use of trailers.

IFF_ALLMULTI Receive all multicast packets.

IFF_MASTER Master of a load balancing bundle.

IFF_SLAVE Slave of a load balancing bundle.

IFF_MULTICAST Supports multicast

IFF_PORTSEL Is able to select media type via ifmap.

IFF_AUTOMEDIA Auto media selection active.

IFF_DYNAMIC The addresses are lost when the interface goes down.

IFF_LOWER_UP Driver signals L1 up (since Linux 2.6.17)

IFF_DORMANT Driver signals dormant (since Linux 2.6.17)

IFF_ECHO Echo sent packets (since Linux 2.6.25)

流量控制策略 qdisc

设备分组 group

设备可以加入到指定分组,有一些命令支持按分组进行操作,比如查看指定分组中的设备:

$ ip link show group default

分组信息记录在 /etc/iproute2/group 中,可以手动在其中添加:

$ cat /etc/iproute2/group

# device group names

0 default

广播地址 brd

(参考链接:5)

参考

- 李佶澳的博客

- ip-link-and-ip-addr-output-meaning

- linux-traffic-control_configuring-and-managing-networking

- tc-fq_codel.8

- meaning-of-brd-in-output-of-ip-commands

iptables 的使用方法

这里是对 iptables:Linux的iptables使用 的重新整理、扩充。

安装 iptables 工具

在 Debian/Ubuntu 上安装:

apt-get update

apt-get install iptables -y

iptables 原理

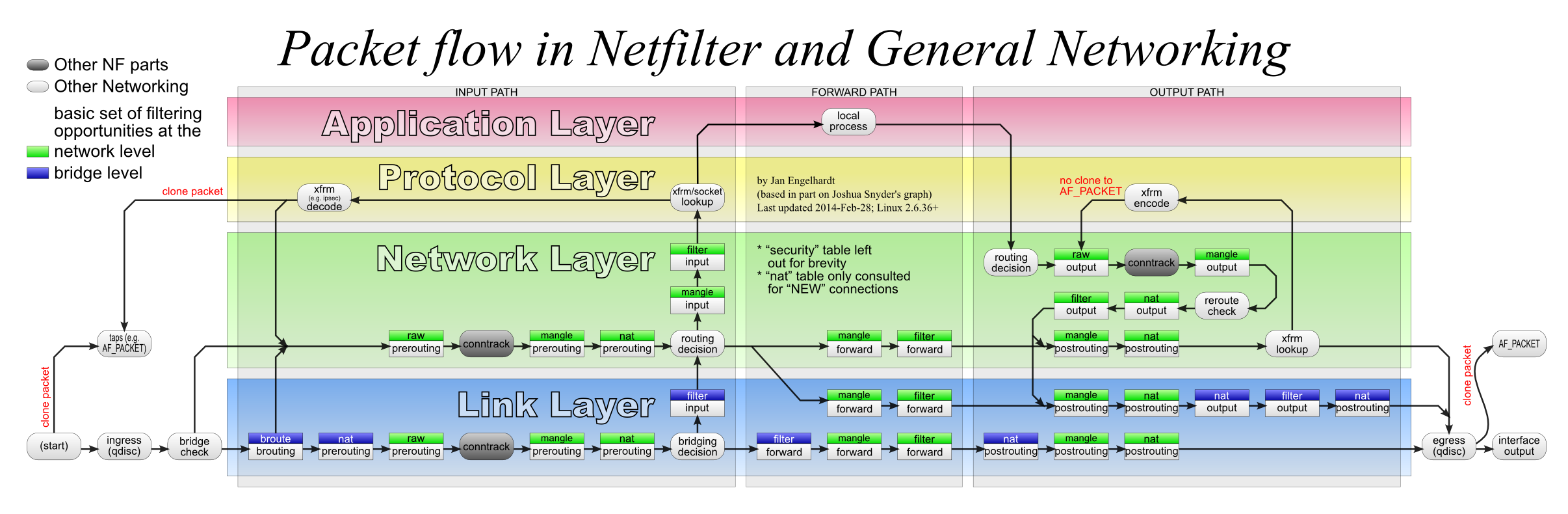

iptables 根植于 kernel 中的 netfilter 模块,通过 netfilter 在影响正在被内核处理的网络报文,一共有 PREROUTING、FORWARD、POSTROUTING、INPUT 和 OUTPUT 5 个干涉点,每个干涉点可以挂一串的处理规则(Chain):

INPUT OUPUT

. |

/_\ +--------+

| _|_

+--------+ \ /

| '

Router --------|> FORWARD

. | |

/_\ +--------+ |

| _|_ _|_

+---------+ \ / \ /

| ' '

PKT ---> PREROUTING POSTROUTING ---> PKT

iptables 的规则管理与作用顺序

iptables 的规则通过 5 张表管理,有的表包括所有的干涉点,有的表只包括部分干涉点:

filter:

Chain INPUT

Chain FORWARD

Chain OUTPUT

nat:

Chain PREROUTING

Chain INPUT

Chain OUTPUT

Chain POSTROUTING

mangle:

Chain PREROUTING

Chain INPUT

Chain FORWARD

Chain OUTPUT

Chain POSTROUTING

raw:

Chain PREROUTING

Chain OUTPUT

security:

Chain INPUT

Chain FORWARD

Chain OUTPUT

上面 5 张表中的 Chain 的作用顺序是固定的,贯穿了报文的处理过程,structure-of-iptables 中有非常详细的说明:

-

进入主机的报文:

raw.PREROUTING -> mangle.PREROUTING -> nat.PREROUTING -> mangle.INPUT -> filter.INPUT

-

经主机转发的报文:

raw.PREROUTING -> mangle.PREROUTING -> nat.PREROUTING -> mangle.FORWARD -> filter.FORWARD -> mangle.POSTROUTING -> nat.POSTROUTING

-

主机发出的报文:

raw.OUTPUT -> mangle.OUTPUT -> nat.OUTPUT -> filter.OUTPUT -> mangle.POSTROUTING ->nat.POSTROUTING

规则格式

规则语法如下:

rule-specification = [matches...] [target]

match = -m matchname [per-match-options]

target = -j targetname [per-target-options]

可以使用的规则参数:

-4, --ipv4

-6, --ipv6

[!] -p, --protocol protocol

可以使用:

1. tcp, udp, udplite, icmp, icmpv6,esp, ah, sctp, mh or the special keyword "all"

2. 协议号,0等同于"all"

3. /etc/protocols中列出的协议名

[!] -s, --source address[/mask][,...]

Address can be either:

a network name, a hostname, a network IP address (with /mask), or a plain IP address.

Multiple addresses can be specified, but this will expand to multiple rules (when

adding with -A), or will cause multiple rules to be deleted (with -D).

[!] -d, --destination address[/mask][,...]

-m, --match match

不同的模块有不同的参数,在下一节中单独讨论

-j, --jump target

-g, --goto chain

Unlike the --jump option return will not continue processing in this chain but instead

in the chain that called us via --jump

[!] -i, --in-interface name

[!] -o, --out-interface name

[!] -f, --fragment

This means that the rule only refers to second and further IPv4 fragments of fragmented packets.

Since there is no way to tell the source or destination ports of such a packet (or ICMP type),

such a packet will not match any rules which specify them.

When the "!" argument precedes the "-f" flag, the rule will only match head fragments, or unfragmented packets.

This option is IPv4 specific, it is not available in ip6tables.

-c, --set-counters packets bytes

This enables the administrator to initialize the packet and byte counters of a rule

(during INSERT, APPEND, REPLACE operations).

怎样用 iptables 实现各种效果,见后面章节。

参考

iptables 的报文匹配方法

iptables 规则的意思就是,对满足什么什么条件的报文,做怎样怎样的处理。第一步就是撰写报文的匹配规则,然后设置处理动作。这里收集 iptables 提供的报文匹配方法。

基本匹配

man iptables 的 PARAMETERS 中列出可以在规则中使用的参数:

-4, --ipv4

-6, --ipv6

[!] -p, --protocol protocol

[!] -s, --source address[/mask][,...]

[!] -d, --destination address[/mask][,...]

[!] -i, --in-interface name

[!] -o, --out-interface name

[!] -f, --fragment # 匹配分片报文

# This means that the rule only refers to second and

# further IPv4 fragments of fragmented packets.

支持的协议

-p 后面的 protocol 可以是数字表示的协议号,可以是下面的字符串(0 和 "all" 表示匹配所有协议),或者 /etc/protocols 中列出的协议名:

tcp, udp, udplite, icmp, icmpv6, esp, ah, sctp, mh, all

$ cat /etc/protocols

# /etc/protocols:

# $Id: protocols,v 1.11 2011/05/03 14:45:40 ovasik Exp $

#

# Internet (IP) protocols

#

# from: @(#)protocols 5.1 (Berkeley) 4/17/89

#

# Updated for NetBSD based on RFC 1340, Assigned Numbers (July 1992).

# Last IANA update included dated 2011-05-03

#

# See also http://www.iana.org/assignments/protocol-numbers

ip 0 IP # internet protocol, pseudo protocol number

hopopt 0 HOPOPT # hop-by-hop options for ipv6

icmp 1 ICMP # internet control message protocol

igmp 2 IGMP # internet group management

...省略...

扩展匹配

基本匹配的规则比较简单,只有协议、源地址、目的地址、接收网卡、发送网卡和分片报文,这几种匹配是远远不够的,iptables 的 -m 参数可以指定扩展模块,实现更复杂、更精细的匹配:

-m, --match match

iptables 提供的扩展模块非常多,种类和用法可以在 man iptables-extensions 中看到。

扩展模块分为 MATCH EXTENSIONS 和 TARGET EXTENSIONS 两类,前者用于报文匹配,后者用于报文处理。

下面是 MATCH EXTENSIONS 列表:

addrtype

ah (IPv6-specific)

ah (IPv4-specific)

bpf

cgroup

cluster

comment

connbytes

connlabel

connlimit

connmark

conntrack

cpu

dccp

devgroup

dscp

dst (IPv6-specific)

ecn

esp

eui64 (IPv6-specific)

frag (IPv6-specific)

hashlimit

hbh (IPv6-specific)

helper

hl (IPv6-specific)

icmp (IPv4-specific)

icmp6 (IPv6-specific)

iprange

ipv6header (IPv6-specific)

ipvs

length

limit

mac

mark

mh (IPv6-specific)

multiport

nfacct

osf

owner

physdev

pkttype

policy

quota

rateest

realm (IPv4-specific)

recent

rpfilter

rt (IPv6-specific)

sctp

set

socket

state

statistic

string

tcp

tcpmss

time

tos

ttl (IPv4-specific)

u32

udp

unclean (IPv4-specific)

匹配特定用户的报文

istio 中用下面的方法,对应用户 1337 启动的 envoy 进程创建的报文单独处理:

-A ISTIO_OUTPUT -m owner --uid-owner 1337 -j RETURN

-A ISTIO_OUTPUT -m owner --gid-owner 1337 -j RETURN

使用用户名也可以:

iptables -t nat -A LOCAL_PROXY -m owner --uid-owner nginx -j RETURN

参考

iptable 的报文处理动作

设置 匹配规则 后,为报文设置处理动作。

报文处理动作用下面是三个参数指定:

-j, --jump target # 使用指定的扩展模块处理报文,处理完成后返回

-g, --goto chain # 跳转到另一条规则链处理

-c, --set-counters packets bytes # 计数器重置

报文处理动作主要是用 -j 指定,-j 也可以像 -g 一样指向另一条规则链。

另一条规则链我们把它称为子链:

- 如果子链是通过

-j跳转的,子链中的 return 动作会终止子链中处理,返回到父链中继续处理 - 如果子链是通过

-g跳转的,子链中的 return 动作会终止子链中处理,且跳过父链的后续规则

Unlike the --jump option return will not continue processing in this chain but instead in the chain that called us via --jump.

基本动作

ACCEPT # 放行报文

DROP # 丢弃报文

RETURN # 返回到上一条规则链中继续处理

扩展动作

大部分处理是用扩展完成的,在 man iptables-extensions 中可以看到支持的扩展动作:

AUDIT

CHECKSUM

CLASSIFY

CLUSTERIP (IPv4-specific)

CONNMARK

CONNSECMARK

CT

DNAT

DNPT (IPv6-specific)

DSCP

ECN (IPv4-specific)

HL (IPv6-specific)

HMARK

IDLETIMER

LED

LOG

MARK

MASQUERADE

MIRROR (IPv4-specific)

NETMAP

NFLOG

NFQUEUE

NOTRACK

RATEEST

REDIRECT

REJECT (IPv6-specific)

REJECT (IPv4-specific)

SAME (IPv4-specific)

SECMARK

SET

SNAT

SNPT (IPv6-specific)

TCPMSS

TCPOPTSTRIP

TEE

TOS

TPROXY

TRACE

TTL (IPv4-specific)

ULOG (IPv4-specific)

报文重定向

REDIRECT 能够在 nat 表的 PREROUTING 和 OUTPUT 链中,将报文的目地 IP 修改为接收到这个报文的网卡的 IP,从而将报文重定向到本地的监听地址。

目标端口如果不指定则不修改,复用原始报文的目标端口:

--to-ports port[-port] # 将目标端口修改为范围内的数值

--random # 为目标端口随机取值

示例,nginx 本地透明代理:

# 新建一个规则链

iptables -t nat -N LOCAL_PROXY

# 不代理 nginx 生成的报文,防止出现 nginx 代理 nginx 的死循环

iptables -t nat -A LOCAL_PROXY -m owner --uid-owner nginx -j RETURN

# 将本地生成的目标端口为 8080 的 tcp 报文,重定向到本地的 :8080 监听地址

iptables -t nat -A LOCAL_PROXY -p tcp -m tcp --dport 8080 -j REDIRECT --to-ports 8080

参考

Linux 的网络设置

Linux 的 Local 地址的认定

127.0.0.1 默认是 local 地址,其实认定为 local 地址的 IP 是可以设置的:

- 在 mangle 表中为要被转发的报文打上标记 1

- 指定带有上述标记的报文使用路由表 100

- 将 0.0.0.0/0(即所有 IP)设置为路由表 100 的 local

iptables -t mangle -I PREROUTING -p udp --dport 5301 -j MARK --set-mark 1

ip rule add fwmark 1 lookup 100

ip route add local 0.0.0.0/0 dev lo table 100

设置上述规则后,所有目标端口为 5301 的 UDP 报文,无论目的地址是多少,都被认为是发送到给本机(local)的。监听本地地址 0.0.0.0:5301,会收到所有目标端口为 5301 的 udp 报文,无论报文的目的 IP 是不是本地 IP。

参考

Linux 的透明代理

TODO: 待试验。

透明代理是 Linux kernel 的功能,用 iptables 或者 nft 命令设置,将发送到地址 A 的报文转发给本地的另一个监听地址,监听改地址的本地进程能够获取到原始的目的地址。

代理报文的通常做法是 REDIRECT,也就是做 NAT,kernel 将报文的目标地址改写为另一个地址,同时将源地址改写为自身的地址,然后维护这两个地址的对应关系。这种方式存在一个明显的弊端,本地接收端不能或者很难获得报文的原始地址。

透明代理是另一种做法,在 kernel 上创建一张路由表,本地接收端(用户态程序)建立监听该路由表中地址的 socket。匹配规则报文被转发给本地接收端后,本地接收端可以用对应的 socket 函数获取原始的目标地址。

内核文档 Transparent proxy support 对该功能有简单说明,Linux transparent proxy support 介绍的更详细。 下面的内容主要来自第二篇文档。

准备本地代理进程

本地代理进程是一个用户态进程,创建一个监听 socket 接收新建连接和报文。监听地址可以是任意需要的 IP 地址,但需要注意,如果不是 0.0.0.0,那么需要使用 IP_TRANSPARENT 选项。认定为 local 的 IP 地址是可以配置的,见 Linux 系统知识/local 地址

本地代理进程从监听 sockert 中读取新建连接,可以自由地将接收的内容转发到另一个地址。

Socket s(AF_INET, SOCK_DGRAM, 0);

SSetsockopt(s, IPPROTO_IP, IP_TRANSPARENT, 1);

ComboAddress local("1.2.3.4", 5300);

ComboAddress remote("198.41.0.4", 53);

SBind(s, local);

SSendto(s, "hi!", remote);

透明代理能够获得原始地址,指的本地代理程序能够用 socket 函数获取报文的原始地址,TCP 协议用 getsockname() 获取 :

Socket s(AF_INET, SOCK_STREAM, 0);

SSetsockopt(s, IPPROTO_IP, IP_TRANSPARENT, 1);

ComboAddress local("127.0.0.1", 10025);

SBind(s, local);

SListen(s, 128);

ComboAddress remote(local), orig(local);

int client = SAccept(s, remote);

cout<<"Got connection from "<<remote.toStringWithPort()<<endl;

SGetsockname(client, orig);

cout<<"Original destination: "<<orig.toStringWithPort()<<endl;

UDP 协议需要用 setsockopt() 设置 IP_RECVORIGDSTADDR,然后从 recvmsg() 收到的 cmsg 中获取,索引为 IP_ORIGDSTADDR。

设置 iptables 规则

准备好本地代理进程后,还需要设置 iptables 规则,将报文转发给本地代理。

在 iptables 规则中使用名为 TPROXY 的 TARGET,也就是透明代理。下面的规则将目标端口是 25 的 TCP 报文以透明代理的方式发送到了本地地址 127.0.0.1:10025。

iptables -t mangle -A PREROUTING -p tcp --dport 25 -j TPROXY \

--tproxy-mark 0x1/0x1 --on-port 10025 --on-ip 127.0.0.1

参考

Linux 的资源管理

cgroup

- 怎样掌握 Linux 的 cgroup?资源限制机制 cgroup 学习指引与概念辨析

- cgroup(一):初级入门使用方法

- cgroup(二):资源限制 cgroup v1 和 cgroup v2 的详细介绍

- cgroup(三):cgroup controller 汇总和控制器的参数(文件接口)

参考

Linux问题分析与性能优化

个人学习笔记,记录Linux相关的知识,性能优化部分的内容主要来自极客时间出品的倪鹏飞专栏《Linux性能优化》。这里使用的操作系统是CentOS,索引了大量参考资料,为了能够查看内核文档,需要在系统上安装man-pages:

yum install -y man-pages

倪朋飞专栏《Linux性能优化》:

排查顺序

整体情况:

top/htop/atop命令查看进程/线程、CPU、内存使用情况,CPU使用情况;dstat 2查看CPU、磁盘IO、网络IO、换页、中断、切换,系统I/O状态;vmstat 2查看内存使用情况,内存状态;iostat -d -x 2查看所有磁盘的IO情况,系统I/O状态;iotop查看IO靠前的进程,系统的I/O状态;perf top查看占用CPU最多的函数,CPU使用情况;perf record -ag -- sleep 15;perf report查看CPU事件占比,CPU使用情况;sar -n DEV 2查看网卡的吞吐,网卡状态;/usr/share/bcc/tools/filetop -C查看每个文件的读写情况,系统的I/O状态;/usr/share/bcc/tools/opensnoop显示正在被打开的文件,系统的I/O状态;

进程分析,进程占用的资源:

pidstat 2 -p 进程号查看可疑进程CPU使用率变化情况;pidstat -w -p 进程号 2查看可疑进程的上下文切换情况;pidstat -d -p 进程号 2查看可疑进程的IO情况;lsof -p 进程号查看进程打开的文件;strace -f -T -tt -p 进程号显示进程发起的系统调用;

协议栈分析,连接/协议栈状态:

netstat -nat|awk '{print awk $NF}'|sort|uniq -c|sort -n查看连接状态分布;ss -ntp或者netstat -ntp查看连接队列;

方法论

RED方法:监控服务的请求数(Rate)、错误数(Errors)、响应时间(Duration)。Weave Cloud在监控微服务性能时提出的思路。

USE方法:监控系统资源的使用率(Utilization)、饱和度(Saturation)、错误数(Errors)。

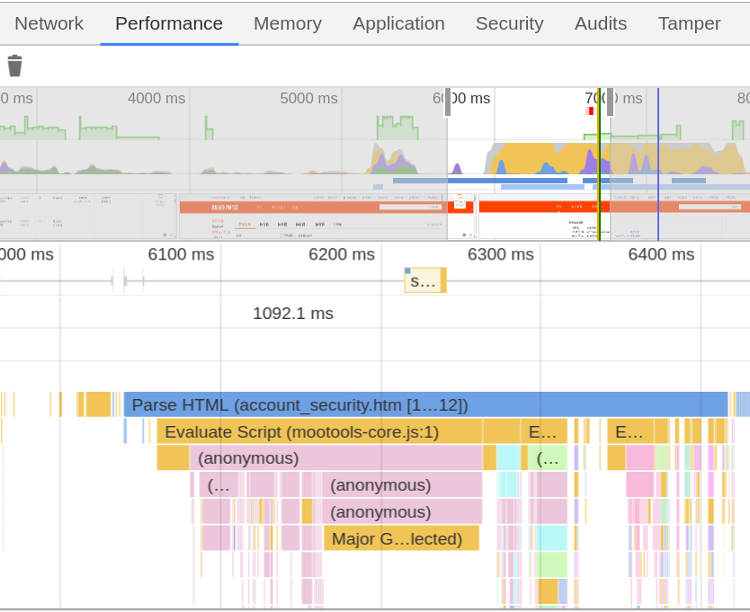

性能分析工具

CPU分析思路

内存分析思路

IO分析思路

网络分析思路

基准测试工具

参考

相当一部分内容来自极客时间出品的倪鹏飞专栏《Linux性能优化》,是这个专栏的学习笔记。

另一份资料是IBM红宝书Linux性能调优指南。

此外,The Linux Documentation Project是一个非常好的资料库。

将硬件中断的处理任务分配个多个CPU:SMP affinity and proper interrupt handling in Linux

Hidden Costs of Memory Allocation

形成认识框架

认识框架(也就是知识大纲)非常重要,宏观上有了理解之后:1)才能有的放矢的深入细节,并能将繁杂多样的细节串联起来;2)在遇到问题的时候,才有能够正确的思考,有头绪、有方法、有步骤的调查问题、解决问题。

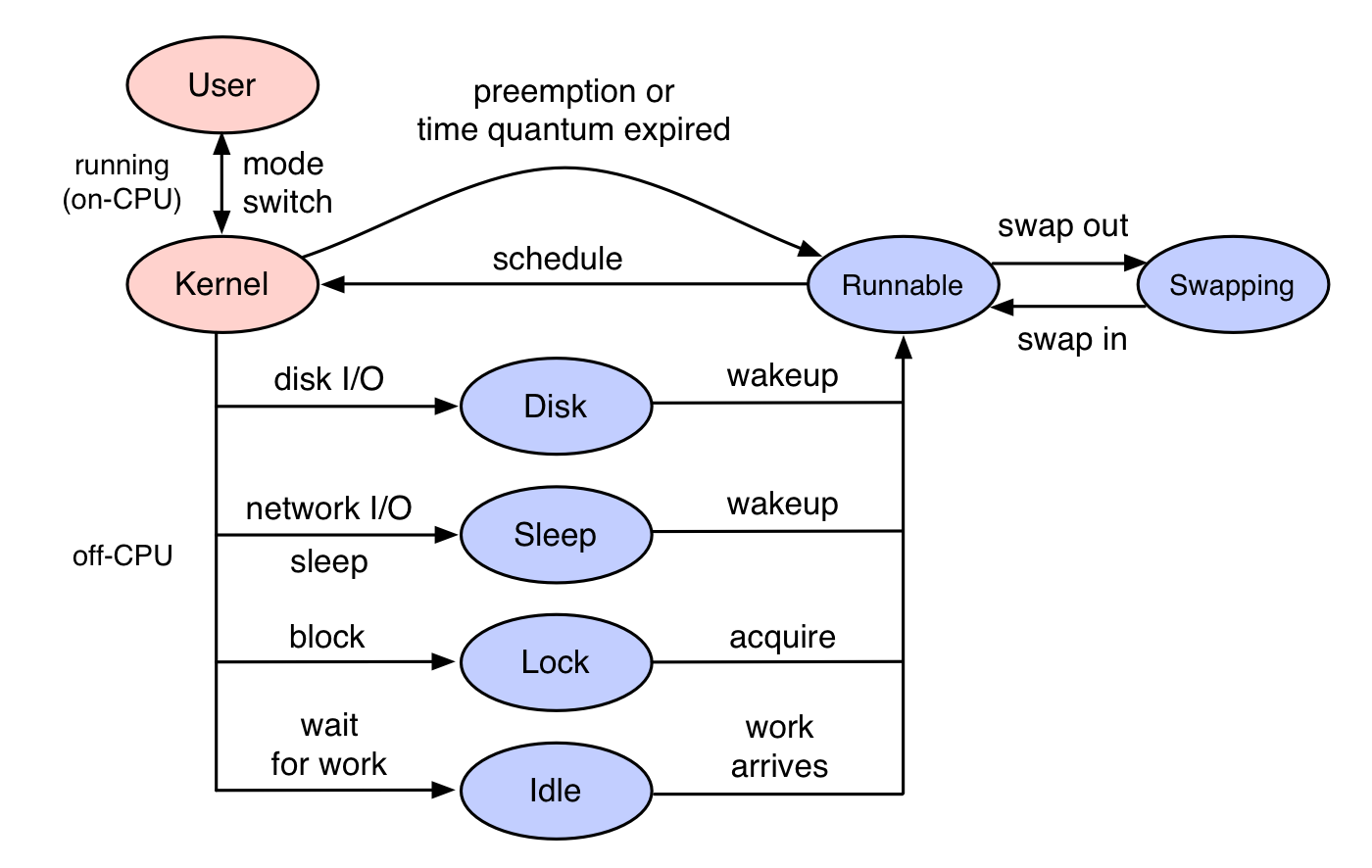

下面这张图是最宏观的图片,从上往下是“应用->库->系统调用->内核->设备”,如果发现一个应用的性能特别不理想,可以按照这个顺序查找问题所在,即先查应用、再查依赖库、然后查系统、最后查硬件。

(图片来源:倪鹏飞,极客时间, [《Linux性能优化]》]1 )

(图片来源:倪鹏飞,极客时间, [《Linux性能优化]》]1 )

Brendan Gregg制作了一份Linux性能工具图谱,这些工具可以用来定位各个方面的问题:

近几年比较流行的eBPF也提供了大量工具,eBPF的介绍见《Linux内核功能eBPF入门学习》:

注意上面两张工具图使用的分类方法(图片中间部分),这个分类就是我们要在头脑中形成记忆的认知框架,有了这个认知框架之后,在遇到性能问题的时候才会有清晰、明确的排查思路,不再抓瞎。

倪鹏飞的Linux性能优化专栏中给出的这张思维导图也是一个不错的知识框架,总共有10部分:性能监控、性能测试、应用程序、架构设计、Linux内核、文件系统、CPU、内存、网络、磁盘。

参考

Linux Kernel相关知识

对kernel了解的越多,性能分析、优化就越顺畅。

参考

动态追踪技术

主要的动态追踪工具有:ftrace、perf、eBPF(bcc)、SystemTap、sysdig。

这里只简单整理一下,以后在实践中加深了解。

如果使用的是新版本内核,eBPF和BCC是最灵活的动态追踪方法,在旧版本的内核中,因为eBPF受限,SystemTap和ftrace是比较好的选择。

ftrace与trace-cmd

ftrace通过debugfs提供用户态接口,debugfs需要事先挂载:

mount -t debugfs nodev /sys/kernel/debug

debugfs中提供多个虚拟文件:

$ ls /sys/kernel/debug/tracing

README instances set_ftrace_notrace trace_marker_raw

available_events kprobe_events set_ftrace_pid trace_options

...

ftrace用起来比较繁琐,trace-cmd简化了ftrace的使用:

yum install trace-cmd

trace-cmd用法:

$ trace-cmd record -p function_graph -g do_sys_open -O funcgraph-proc ls

$ trace-cmd report

...

ls-12418 [000] 85558.075341: funcgraph_entry: | do_sys_open() {

ls-12418 [000] 85558.075363: funcgraph_entry: | getname() {

ls-12418 [000] 85558.075364: funcgraph_entry: | getname_flags() {

ls-12418 [000] 85558.075364: funcgraph_entry: | kmem_cache_alloc() {

ls-12418 [000] 85558.075365: funcgraph_entry: | _cond_resched() {

ls-12418 [000] 85558.075365: funcgraph_entry: 0.074 us | rcu_all_qs();

ls-12418 [000] 85558.075366: funcgraph_exit: 1.143 us | }

ls-12418 [000] 85558.075366: funcgraph_entry: 0.064 us | should_failslab();

ls-12418 [000] 85558.075367: funcgraph_entry: 0.075 us | prefetch_freepointer();

ls-12418 [000] 85558.075368: funcgraph_entry: 0.085 us | memcg_kmem_put_cache();

ls-12418 [000] 85558.075369: funcgraph_exit: 4.447 us | }

ls-12418 [000] 85558.075369: funcgraph_entry: | __check_object_size() {

ls-12418 [000] 85558.075370: funcgraph_entry: 0.132 us | __virt_addr_valid();

ls-12418 [000] 85558.075370: funcgraph_entry: 0.093 us | __check_heap_object();

ls-12418 [000] 85558.075371: funcgraph_entry: 0.059 us | check_stack_object();

ls-12418 [000] 85558.075372: funcgraph_exit: 2.323 us | }

ls-12418 [000] 85558.075372: funcgraph_exit: 8.411 us | }

ls-12418 [000] 85558.075373: funcgraph_exit: 9.195 us | }

...

perf 跟踪内核函数

查看perf支持的事件:

$ perf list

List of pre-defined events (to be used in -e):

alignment-faults [Software event]

context-switches OR cs [Software event]

cpu-clock [Software event]

cpu-migrations OR migrations [Software event]

dummy [Software event]

emulation-faults [Software event]

...

添加探针:

$ perf probe --add do_sys_open

Added new event:

probe:do_sys_open (on do_sys_open)

You can now use it in all perf tools, such as:

perf record -e probe:do_sys_open -aR sleep 1

使用探针采样:

$ perf record -e probe:do_sys_open -aR sleep 10

[ perf record: Woken up 1 times to write data ]

[ perf record: Captured and wrote 0.148 MB perf.data (19 samples) ]

查看采样结果:

$ perf script

perf 12886 [000] 89565.879875: probe:do_sys_open: (ffffffffa807b290)

sleep 12889 [000] 89565.880362: probe:do_sys_open: (ffffffffa807b290)

sleep 12889 [000] 89565.880382: probe:do_sys_open: (ffffffffa807b290)

sleep 12889 [000] 89565.880635: probe:do_sys_open: (ffffffffa807b290)

sleep 12889 [000] 89565.880669: probe:do_sys_open: (ffffffffa807b290)

查看内核函数的参数,需要安装debufinfo:

yum --enablerepo=base-debuginfo install -y kernel-debuginfo-$(uname -r):

$ perf probe -V do_sys_open

Available variables at do_sys_open

@<do_sys_open+0>

char* filename

int dfd

int flags

struct open_flags op

umode_t mode

删除探针:

perf probe --del probe:do_sys_open

添加带参数的探针:

$ perf probe --add 'do_sys_open filename:string'

Added new event:

probe:do_sys_open (on do_sys_open with filename:string)

You can now use it in all perf tools, such as:

perf record -e probe:do_sys_open -aR sleep 1

采样结果将是这样的:

$ perf script

perf 13593 [000] 91846.053622: probe:do_sys_open: (ffffffffa807b290) filename_string="/proc/13596/status"

ls 13596 [000] 91846.053995: probe:do_sys_open: (ffffffffa807b290) filename_string="/etc/ld.so.cache"

ls 13596 [000] 91846.054011: probe:do_sys_open: (ffffffffa807b290) filename_string="/lib/x86_64-linux-gnu/libselinux.so.1"

ls 13596 [000] 91846.054066: probe:do_sys_open: (ffffffffa807b290) filename_string="/lib/x86_64-linux-gnu/libc.so.6”

...

perf 跟踪链接库函数

查看指定二进制文件(-x /bin/bash)可以追踪的所有的函数:

$ perf probe -x /bin/bash —funcs

查看函数的参数,需要安装有对应的debuginfo:

$ perf probe -x /bin/bash -V readline

Available variables at readline

@<readline+0>

char* prompt

为 /bin/bash 添加 readline 探针:

$ perf probe -x /bin/bash 'readline%return +0($retval):string’

开始采样:

$ perf record -e probe_bash:readline__return -aR sleep 5

查看结果:

$ perf script

bash 13348 [000] 93939.142576: probe_bash:readline__return: (5626ffac1610 <- 5626ffa46739) arg1="ls"

删除探针

$ perf probe --del probe_bash:readline__return

perf trace 与 trace

trace命令通过系统调用ptrace获取进程的调用系统情况,它会频繁在内核态和用户态切换,影响目标进程的性能,ptrace又会用SIGSTOP信号挂起目标进程,影响目标进程的行为。

perf trace基于内核事件,性能要好很多:

$ perf trace ls

? ( ): ls/14234 ... [continued]: execve()) = 0

0.177 ( 0.013 ms): ls/14234 brk( ) = 0x555d96be7000

0.224 ( 0.014 ms): ls/14234 access(filename: 0xad98082 ) = -1 ENOENT No such file or directory

0.248 ( 0.009 ms): ls/14234 access(filename: 0xad9add0, mode: R ) = -1 ENOENT No such file or directory

0.267 ( 0.012 ms): ls/14234 openat(dfd: CWD, filename: 0xad98428, flags: CLOEXEC ) = 3

0.288 ( 0.009 ms): ls/14234 fstat(fd: 3</usr/lib/locale/C.UTF-8/LC_NAME>, statbuf: 0x7ffd2015f230 ) = 0

0.305 ( 0.011 ms): ls/14234 mmap(len: 45560, prot: READ, flags: PRIVATE, fd: 3 ) = 0x7efe0af92000

0.324 Dockerfile test.sh

( 0.008 ms): ls/14234 close(fd: 3</usr/lib/locale/C.UTF-8/LC_NAME> ) = 0

...

eBPF和BCC

eBPF以及BCC的原理和用途,以及BCC系列工具的用法:

- Linux内核功能eBPF入门学习(一):BPF、eBPF、BCC等基本概念

- Linux内核功能eBPF入门学习(二):BCC中的eBPF应用与bpftrace等

- BCC Tutorial

- BCC Python Developer Tutorial

- BPF Features by Linux Kernel Version

CentOS中用yum直接安装,有协议额

yum install bcc-tools

命令安装在/usr/share/bcc/tools/中:

$ ls /usr/share/bcc/tools/

argdist dbstat javacalls offcputime rubyobjnew tcplife

bashreadline dcsnoop javaflow offwaketime rubystat tcpretrans

biolatency dcstat javagc oomkill runqlat tcpstates

如果遇到下面的错误,说明内核版本太低,不支持相关特性:

[root@prod-k8s-node-138-127 phops]# /usr/share/bcc/tools/execsnoop

In file included from <built-in>:2:

/virtual/include/bcc/bpf.h:13:10: fatal error: 'linux/bpf_common.h' file not found

#include <linux/bpf_common.h>

^~~~~~~~~~~~~~~~~~~~

1 error generated.

Traceback (most recent call last):

File "/usr/share/bcc/tools/execsnoop", line 166, in <module>

b = BPF(text=bpf_text)

File "/usr/lib/python2.7/site-packages/bcc/__init__.py", line 318, in __init__

raise Exception("Failed to compile BPF text")

Exception: Failed to compile BPF text

BPF Features by Linux Kernel Version汇总了每个特性需要的最低内核版本,下图提供了部分信息:

BCC Python Developer Tutorial中介绍了eBPF应用程序的开发方法,掌握以后可以自行开发追踪工具。

支持旧内核的SystemTap

和eBPF根植于内核不同,SystemTap是独立于内核的,并且在RHEL系统中好用,在其它发行版上容易出现各种异常问题。eBPF是比较新的内核特性,对内核版本要求高,SystemTap的先于eBPF诞生,支持3.x等旧版本的内核。

容器动态追踪sysdig

Sysdig vs DTrace vs Strace: a Technical Discussion

参考

CPU 相关知识

这里记录CPU相关的知识。

参考

CPU的运行状态

CPU一共有多种工作状态,其中只有idle状态是空闲状态。

top命令显示过去2秒(2s是默认值,可以用-d参数修改)中,每个CPU在每个状态中停留的时间比例:

%Cpu(s): 14.5 us, 0.3 sy, 0.0 ni, 85.2 id, 0.0 wa, 0.0 hi, 0.0 si, 0.0 st

us是CPU在用户态的时间比例,sy是CPU在内核态的时间比例,其它指标含义如下:

us, user : time running un-niced user processes

sy, system : time running kernel processes

ni, nice : time running niced user processes

id, idle : time spent in the kernel idle handler

wa, IO-wait : time waiting for I/O completion

hi : time spent servicing hardware interrupts

si : time spent servicing software interrupts

st : time stolen from this vm by the hypervisor

在man top和中可以找到这些说明。另外man proc给出了更多状态说明:

user (1) Time spent in user mode.

nice (2) Time spent in user mode with low priority (nice).

system (3) Time spent in system mode.

idle (4) Time spent in the idle task.

This value should be USER_HZ times the second entry in the /proc/uptime pseudo-file.

iowait (since Linux 2.5.41)

(5) Time waiting for I/O to complete.

irq (since Linux 2.6.0-test4)

(6) Time servicing interrupts.

softirq (since Linux 2.6.0-test4)

(7) Time servicing softirqs.

steal (since Linux 2.6.11)

(8) Stolen time, which is the time spent in other operating systems when running in a virtualized environment

guest (since Linux 2.6.24)

(9) Time spent running a virtual CPU for guest operating systems under the control of the Linux kernel.

guest_nice (since Linux 2.6.33)

(10) Time spent running a niced guest (virtual CPU for guest operating systems under the control of the Linux kernel).

Understanding CPU Steal Time - when should you be worried?中详细介绍了steal time,如果steal time占比持续20分钟超过10%,vm性能可能受到了显著影响。

CPU使用率的计算

CPU使用率计算方法是:1-空闲时间/CPU总时间。

CPU处于每种状态的时间

top中会显示CPU在每个状态的时间占比,这些数据来自于/proc/stat,这个文件中记录每个CPU在每种模式下耗费的时间分片数量,第一行是所有CPU的数值的累加:

$ cat /proc/stat

cpu 2295737 1270 903726 238996130 61210 0 90996 27778 0 0

cpu0 435456 334 213700 59922519 15305 0 18523 6715 0 0

cpu1 626136 317 229817 59638019 15702 0 35754 7526 0 0

cpu2 635052 320 237094 59685588 15354 0 18630 6930 0 0

cpu3 599092 297 223113 59750002 14847 0 18087 6605 0 0

...

注意:/proc/stat中数值的单位不是秒/毫秒,而是时间分片的个数:

The amount of time, measured in units of USER_HZ (1/100ths of a second on most architectures,

use sysconf(_SC_CLK_TCK) to obtain the right value), that the system spent in vari‐

每个时间分片时长是1/100秒。

用户态与内核态的详细说明

用户态和内核态其实是CPU的工作模式,一些特殊的指令可以让CPU在用户态和内核态的切换。 CPU在内核态时,操作的是内核中的数据,用户态时操作的是用户态数据。

用户态进程是通过发起系统调用,进入到内核态的。

系统调用可以理解为内核提供的功能接口,用户态程序发起系统调用的时候,CPU转为内核态,完成了相关操作后,再切换回用户态。

参考

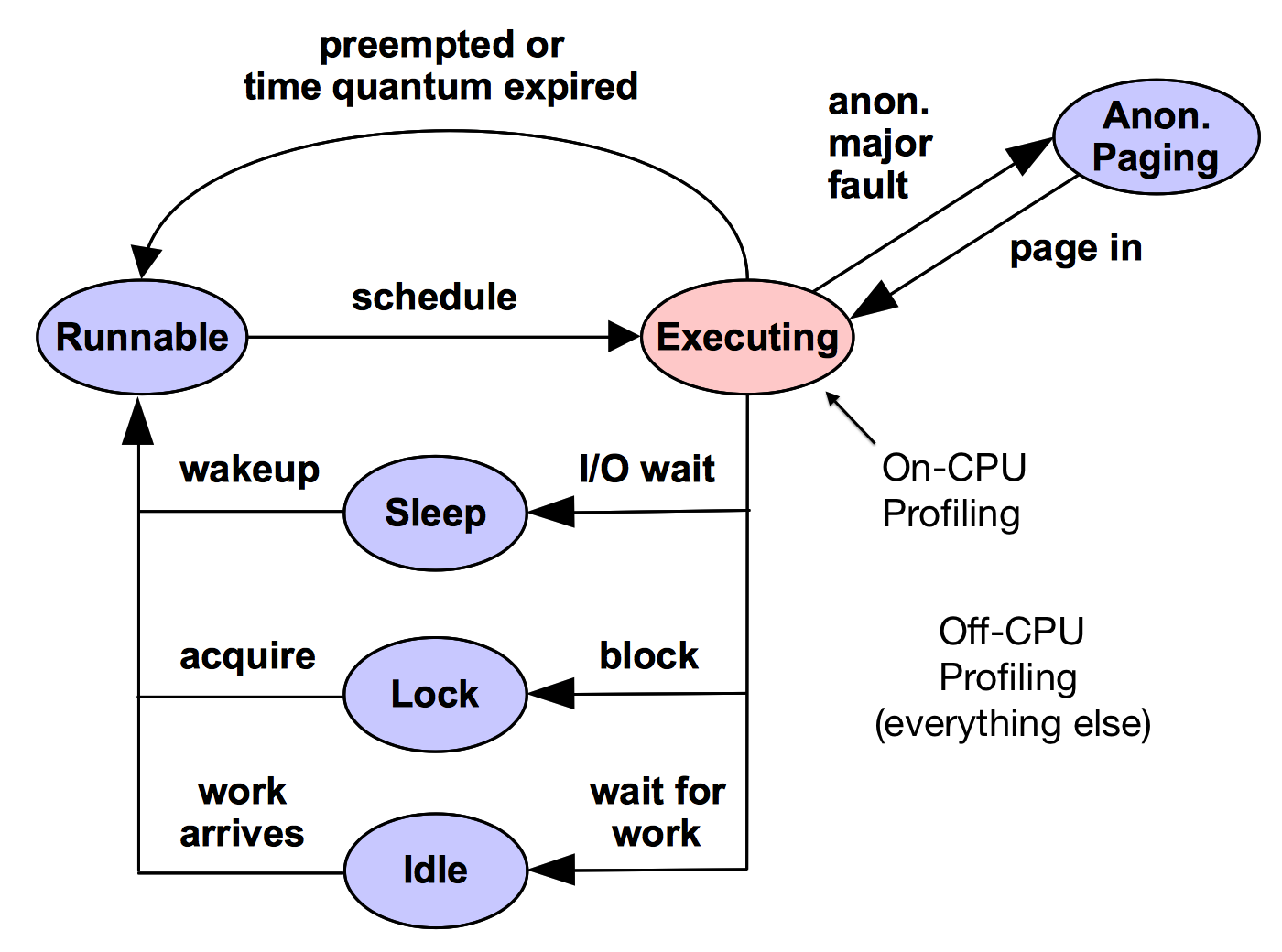

CPU运行上下文的切换

CPU上下文就是CPU中所有寄存器、计数器的快照,是CPU工作环境。当CPU要执行另一个进程的时候,需要将一些寄存器的数值修改为目标进程的相应值,这个过程叫做CPU上下文切换。

CPU上下文切换发生在这几个场景中:

- 特权模式切换(系统调用)

- 进程上下文切换

- 线程上下文切换

- 中断上下文切换

特权模式切换(系统调用)

在Linux中,CPU特权模式切换就是用户态和内核态的切换,用户态进程通过调用系统调用进入到内核态,这个过程中一些特殊的CPU指令会被执行,将CPU切换特权模式,CPU的上下文也随之切换,切入切回,一次系统调用伴随着两次上下文切换。

第一次切换:调用系统调用时候,保存用户态的状态,然后切换到内核态,加载内核态代码。

第二次切换:内核态的系统调用处理代码执行结束后,退出特权模式,加载之前保留的用户态状态。

系统调用的切换过程中一直都是一个进程,和进程与进程的切换不同,不涉及虚拟内存等用户态资源。

进程上下文切换

进程是内核管理调度的,切换过程在内核态进行。相比系统调用中的切换,进程切换时需要保留更多状态数据,例如虚拟内存、栈、全局变量,和内核堆栈、寄存器数值。

进程上下文切换时,先保留当前进程的状态,然后加载下一个进程的状态,每次切换需要几十纳秒到几微妙的时间,开销比较大。(硬件寄存器的缓存需要被重新刷新,也使执行效率受到影响,在多核的机器,进程还可能在不同CPU核心上移动)

进程上下文切换是不可避免的,通常情况下,进程的数量一定是远远超过CPU核心数的,进程不能独占CPU,需要接受内核的调度,每次调度都会触发进程切换。

引发内核重新调度的因素有:

- 正在运行的进程的当前时间片耗尽

- 系统资源不足(譬如内存),进程需要等待

- 进程通过sleep等函数,将自己挂起

- 出现了优先级更高的进程(内核需要设置为支持抢占)

- 发生硬件中断,被切换到中断服务程序(注意,软中断不会触发切换)

如果一个进程因为被频繁地切换上下文,导致效率不高,可以将进程绑定指定CPU核心上。

线程上下文切换

进程是资源拥有的基本单位,线程是调度的基本单位。一个进程对应至少一个线程,可以对应多个线程。

隶属于同一个继承的线程间进行上下文切换的开销相对较小,因为它们有一部分共用的数据,这些数据可以免除切换。

中断上下文切换

中断通常是硬件发出的,也可以用实现“软中断”,中断发生后,CPU通常需要停下当前的工作,优先处理中断实现,指定中断事件对应的指令。

中断只发生在内核态。

中断会打断其它进程的调度和执行,带来额外的开销,如果中断次数过多,会显著降低整体系统。

参考

Linux中查看CPU的使用情况

CPU使用分析主要就是分析CPU的使用率,看看那些进程占用的CPU资源比较多。

top/htop/atop查看CPU使用情况

top命令不多说了,需要注意的是在top中键入H后,进入线程模式。

htop和atop是两个功能更丰富的类top工具:

yum install -y htop atop

pidstat查看进程的CPU使用率

pidstat命令可以显示每个进程的在不同CPU状态中耗费的时间的百分比(1,每秒显示一次;-p,指定进程,如果不指定,显示所有进程):

$ pidstat 1 -p 27936

Linux 3.10.0-693.11.6.el7.x86_64 (10.10.64.58) 12/04/2018 _x86_64_ (4 CPU)

05:00:59 PM UID PID %usr %system %guest %CPU CPU Command

05:01:00 PM 99 27936 0.00 0.00 0.00 0.00 0 openresty

05:01:01 PM 99 27936 0.00 0.00 0.00 0.00 0 openresty

05:01:02 PM 99 27936 0.00 0.00 0.00 0.00 0 openresty

perf top查看CPU占用高的函数

perf top显示占用CPU时间最多的函数或者指令:

$ perf top

Samples: 3K of event 'cpu-clock', Event count (approx.): 903937500

Overhead Shared Object Symbol

8.69% perf [.] symbols__insert

5.33% perf [.] rb_next

3.41% [kernel] [k] _raw_spin_unlock_irqrestore

3.12% libc-2.17.so [.] __memcpy_ssse3_back

2.40% [kernel] [k] finish_task_switch

2.40% libc-2.17.so [.] __strchr_sse42

2.08% libelf-0.168.so [.] gelf_getsym

...省略后续内容...

perf report查看cpu事件占比

用perf record将采样数据保存,然后用perf record查看,或者直接用下面的命令一次完成,-a查看所有cpu:

perf record -ag -- sleep 15;perf report

perf report中显示,stress进程的cpu事件占比是77%,它大量调用了随机数生成函数random():

vmstat查看上下文切换

vmstat命令显示系统整体状态,输出如下:

$ vmstat

procs -----------memory---------- ---swap-- -----io---- -system-- ------cpu-----

r b swpd free buff cache si so bi bo in cs us sy id wa st

1 0 5980 126076 648 6997448 0 0 6 27 13 1 1 1 97 0 0

可以在后面加上一个数字,每隔指定时间输出一次,例如vmstat 5,如果感觉数据排列太密集,可以加上参数-w,用宽格式显示。

vmstat命令的输出包含procs、memory、 swap、io、system和cpu六块内容。

每列数据的含义如下,可以在man vmstat中找到:

Procs

r: The number of runnable processes (running or waiting for run time).

b: The number of processes in uninterruptible sleep.

Memory

swpd: the amount of virtual memory used.

free: the amount of idle memory.

buff: the amount of memory used as buffers.

cache: the amount of memory used as cache.

inact: the amount of inactive memory. (-a option)

active: the amount of active memory. (-a option)

Swap

si: Amount of memory swapped in from disk (/s).

so: Amount of memory swapped to disk (/s).

IO

bi: Blocks received from a block device (blocks/s).

bo: Blocks sent to a block device (blocks/s).

System

in: The number of interrupts per second, including the clock.

cs: The number of context switches per second.

CPU

These are percentages of total CPU time.

us: Time spent running non-kernel code. (user time, including nice time)

sy: Time spent running kernel code. (system time)

id: Time spent idle. Prior to Linux 2.5.41, this includes IO-wait time.

wa: Time spent waiting for IO. Prior to Linux 2.5.41, included in idle.

st: Time stolen from a virtual machine. Prior to Linux 2.6.11, unknown.

其中cs是一秒内发生的上下文切换次数。

pidstat查看特定进程的切换情况

pidstat -w可以显示每个进程的上下文切换情况:

$ pidstat -w

Linux 3.10.0-693.11.6.el7.x86_64 (10.10.64.58) 12/04/2018 _x86_64_ (4 CPU)

04:04:15 PM UID PID cswch/s nvcswch/s Command

04:04:15 PM 0 1 1.75 0.00 systemd

04:04:15 PM 0 2 0.01 0.00 kthreadd

04:04:15 PM 0 3 2.54 0.00 ksoftirqd/0

...省略后续内容...

(可以在后面上一个数字,每隔指定时间输出一次,例如pidstat -w 5)

特别注意:pidstats -w显示的是进程的状态,如果要将线程一并显示出来,需要再加一个-t参数:

$ pidstat -wt

Average: UID TGID TID cswch/s nvcswch/s Command

Average: 0 3 - 3.92 0.00 ksoftirqd/0

Average: 0 - 3 3.92 0.00 |__ksoftirqd/0

Average: 0 9 - 45.59 0.00 rcu_sched

Average: 0 - 9 45.59 0.00 |__rcu_sched

Average: 0 13 - 1.96 0.00 ksoftirqd/1

Average: 0 - 13 1.96 0.00 |__ksoftirqd/1

Average: 0 17 - 0.49 0.00 migration/2

...省略后续内容...

-w参数的作用是显示进程切换状态,每一列的含义如下(可以在man pidstat中找到):

-w Report task switching activity (kernels 2.6.23 and later only).

The following values may be displayed:

UID

The real user identification number of the task being monitored.

USER

The name of the real user owning the task being monitored.

PID

The identification number of the task being monitored.

cswch/s

Total number of voluntary context switches the task made per second.

A voluntary context switch occurs when a task blocks because it requires

a resource that is unavailable.

nvcswch/s

Total number of non voluntary context switches the task made per second.

A involuntary context switch takes place when a task executes for the duration

of its time slice and then is forced to relinquish the processor.

Command

The command name of the task.

需要注意自愿切换(cswch/s,voluntary context switches)和非自愿切换(nvcswch/s,non voluntary context switches)的区别。前者是因为需要的资源没有准备好,主动让出CPU发生的切换,后者是进程分配的时间片已经用完,被调度器强制切换。

另外pidstat还有一个-u参数,可以一并输出进程和线程(加-t)的CPU使用情况:

[[email protected] ~]# pidstat -wt -u

Linux 3.10.0-693.11.6.el7.x86_64 (10.10.64.58) 12/04/2018 _x86_64_ (4 CPU)

04:21:56 PM UID TGID TID %usr %system %guest %CPU CPU Command

04:21:56 PM 0 1 - 0.02 0.01 0.00 0.03 0 systemd

04:21:56 PM 0 - 1 0.02 0.01 0.00 0.03 0 |__systemd

04:21:56 PM 0 2 - 0.00 0.00 0.00 0.00 0 kthreadd

04:21:56 PM 0 - 2 0.00 0.00 0.00 0.00 0 |__kthreadd

...省略后续内容...

04:21:56 PM UID TGID TID cswch/s nvcswch/s Command

04:21:56 PM 0 1 - 1.75 0.00 systemd

04:21:56 PM 0 - 1 1.75 0.00 |__systemd

04:21:56 PM 0 2 - 0.01 0.00 kthreadd

04:21:56 PM 0 - 2 0.01 0.00 |__kthreadd

04:21:56 PM 0 3 - 2.53 0.00 ksoftirqd/0

...省略后续内容...

/proc/interrupts记录的中断状态

watch -d cat /proc/interrupts用可以显示中断的变化情况。

Every 2.0s: cat /proc/interrupts Tue Dec 4 16:29:25 2018

CPU0 CPU1 CPU2 CPU3

0: 153 0 0 0 IO-APIC-edge timer

1: 10 0 0 0 IO-APIC-edge i8042

6: 3 0 0 0 IO-APIC-edge floppy

8: 0 0 0 0 IO-APIC-edge rtc0

9: 0 0 0 0 IO-APIC-fasteoi acpi

10: 0 0 0 0 IO-APIC-fasteoi virtio0

11: 31 0 3 0 IO-APIC-fasteoi uhci_hcd:usb1

12: 15 0 0 0 IO-APIC-edge i8042

14: 0 0 0 0 IO-APIC-edge ata_piix

15: 0 0 0 0 IO-APIC-edge ata_piix

24: 0 0 0 0 PCI-MSI-edge virtio3-config

25: 6234 0 120283 272843 PCI-MSI-edge virtio3-req.0

26: 0 0 0 0 PCI-MSI-edge virtio1-config

27: 99 176029503 172147021 0 PCI-MSI-edge virtio1-input.0

28: 24 2721 497 4165 PCI-MSI-edge virtio1-output.0

29: 0 0 0 0 PCI-MSI-edge virtio2-config

30: 19 0 0 0 PCI-MSI-edge virtio2-virtqueues

31: 0 0 0 0 PCI-MSI-edge virtio4-config

32: 131111 0 0 0 PCI-MSI-edge virtio4-req.0

NMI: 0 0 0 0 Non-maskable interrupts

LOC: 64284244 70653905 70450086 65741168 Local timer interrupts

SPU: 0 0 0 0 Spurious interrupts

PMI: 0 0 0 0 Performance monitoring interrupts

IWI: 1242971 1424513 1360783 1296367 IRQ work interrupts

RTR: 0 0 0 0 APIC ICR read retries

RES: 33708963 29562936 30300354 32946303 Rescheduling interrupts

CAL: 131150935 64213698 67023823 133615842 Function call interrupts

TLB: 519133 541110 531432 522850 TLB shootdowns

TRM: 0 0 0 0 Thermal event interrupts

THR: 0 0 0 0 Threshold APIC interrupts

DFR: 0 0 0 0 Deferred Error APIC interrupts

MCE: 0 0 0 0 Machine check exceptions

MCP: 2001 2001 2001 2001 Machine check polls

ERR: 0

MIS: 0

PIN: 0 0 0 0 Posted-interrupt notification event

PIW: 0 0 0 0 Posted-interrupt wakeup event

Rescheduling interrupts是重调度中断,用来唤醒空闲的CPU执行新的任务。

参考

内存相关的知识

参考

Linux的内存管理方法

虚拟内存地址空间划分

虚拟内存与物理内存的映射

NUMA:node独立内存

在NUMA架构(多CPU)下,每个node(物理CPU)都有自己的本地内存,在分析内存的时候需要分析每个node的情况:

$ numactl --hardware

available: 1 nodes (0)

node 0 cpus: 0 1

node 0 size: 7977 MB

node 0 free: 4416 MB

...

/proc/sys/vm/zone_reclaim_mode设置NUMA本地内存的回收策略,当node本地内存不足时,默认可以从其它node寻找空闲内存,也可以从本地回收。

Swap

Swap的设置开启:

# 创建 Swap 文件

$ fallocate -l 8G /mnt/swapfile

# 修改权限只有根用户可以访问

$ chmod 600 /mnt/swapfile

# 配置 Swap 文件

$ mkswap /mnt/swapfile

# 开启 Swap

$ swapon /mnt/swapfile

sar显示Swap的使用情看,-r 表示显示内存使用情况,-S 表示显示 Swap 使用情况:

$ sar -r -S 1

04:39:56 kbmemfree kbavail kbmemused %memused kbbuffers kbcached kbcommit %commit kbactive kbinact kbdirty

04:39:57 6249676 6839824 1919632 23.50 740512 67316 1691736 10.22 815156 841868 4

04:39:56 kbswpfree kbswpused %swpused kbswpcad %swpcad

04:39:57 8388604 0 0.00 0 0.00

04:39:57 kbmemfree kbavail kbmemused %memused kbbuffers kbcached kbcommit %commit kbactive kbinact kbdirty

04:39:58 6184472 6807064 1984836 24.30 772768 67380 1691736 10.22 847932 874224 20

04:39:57 kbswpfree kbswpused %swpused kbswpcad %swpcad

04:39:58 8388604 0 0.00 0 0.00

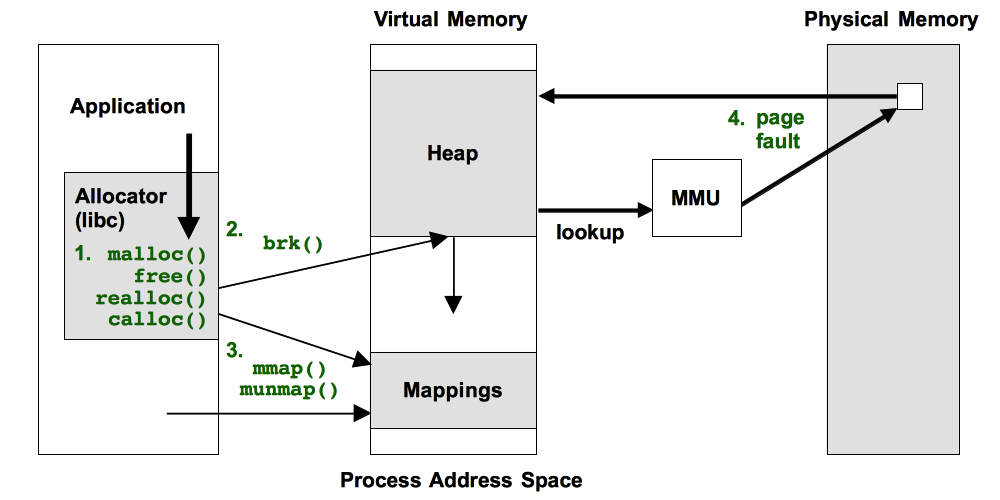

内存分配:brk()与mmap()

brk()分配的是堆中的内存,这些内存释放以后不会被立刻归还系统,而是被缓存起来重复使用。brk()会缓存获得的物理内存页,减少缺页异常,但是频繁的内存分配和释放会造成内存碎片。

mmap()分配的文件映射段的内存,释放时直接归还系统,下载再使用要再次触发缺页异常,让内核分配对应的物理内存。 mmap()直接归还获得的物理内存页,每次都会触发缺页异常,频繁内存分配会增加内核压力。

在C标准库中,小于128K的内存用brk()分配,大于128K的内存用mmap()分配。

内核内存:伙伴系统

内核用伙伴系统管理内存分配。

内存泄露

BCC中的memleak用来检测内存泄露:

$ /usr/share/bcc/tools/memleak -p $(pidof app) -a

Attaching to pid 12512, Ctrl+C to quit.

[03:00:41] Top 10 stacks with outstanding allocations:

addr = 7f8f70863220 size = 8192

addr = 7f8f70861210 size = 8192

addr = 7f8f7085b1e0 size = 8192

addr = 7f8f7085f200 size = 8192

addr = 7f8f7085d1f0 size = 8192

40960 bytes in 5 allocations from stack

fibonacci+0x1f [app]

child+0x4f [app]

start_thread+0xdb [libpthread-2.27.so]

参考

内存缓存

buffer与cache

free的命令中有一栏是buff/cache,buffer和cache都是内存缓存,但是又有区别。

$ free

total used free shared buff/cache available

Mem: 32731868 1170284 28024100 254420 3537484 30824636

Swap: 67108860 3376124 63732736

buffer中缓存的是将要写到磁盘的数据,通过合并写的方式提高写入效率。

cache中缓存的是从磁盘读取的数据。

缓存命中率

BCC中的cachestat和cachetop分别用来查看整个系统的缓存读写命中情况、每个进程的缓存命中情况。

$ cachestat 1 3

TOTAL MISSES HITS DIRTIES BUFFERS_MB CACHED_MB

2 0 2 1 17 279

2 0 2 1 17 279

2 0 2 1 17 279

TOTAL是总的IO次数,DIRTIES是新增到缓存中的脏页。

$ cachetop

11:58:50 Buffers MB: 258 / Cached MB: 347 / Sort: HITS / Order: ascending

PID UID CMD HITS MISSES DIRTIES READ_HIT% WRITE_HIT%

13029 root python 1 0 0 100.0% 0.0%

文件的缓存大小

pcstat用来查看一个文件的缓存大小:

$ pcstat /bin/ls

+---------+----------------+------------+-----------+---------+

| Name | Size (bytes) | Pages | Cached | Percent |

|---------+----------------+------------+-----------+---------|

| /bin/ls | 133792 | 33 | 0 | 000.000 |

+---------+----------------+------------+-----------+---------+

pcstat的安装方法:

$ go get golang.org/x/sys/unix

$ go get github.com/tobert/pcstat/pcstat

在测试文件读写性能的时候,要清理缓存:

$ echo 3 > /proc/sys/vm/drop_caches

参考

查看内存状态

vmstat查看内存状态

$ vmstat 1

procs -----------memory---------- ---swap-- -----io---- -system-- ------cpu-----

r b swpd free buff cache si so bi bo in cs us sy id wa st